Fusion de Capteurs pour la Robotique Autonome en 2025 : Comment l’Intelligence Multi-Capteur Alimente la Prochaine Vague d’Innovation Autonome. Explorez la Croissance du Marché, les Technologies Révolutionnaires et les Perspectives Stratégiques pour les Années à Venir.

- Résumé Exécutif : Résultats Clés & Points Forts du Marché

- Aperçu du Marché : Définir la Fusion de Capteurs dans la Robotique Autonome

- Taille du Marché 2025 & Prévisions de Croissance (CAGR 2025–2030) : Tendances, Facteurs et Projections

- Paysage Concurrentiel : Acteurs Principaux, Startups et Alliances Stratégiques

- Plongée Technologique : Types de Capteurs, Architectures et Approches d’Intégration

- IA & Apprentissage Automatique dans la Fusion de Capteurs : Permettre une Robotique Plus Intelligente

- Segments d’Application : Industrie, Automobile, Drones, Santé, et Plus

- Analyse Régionale : Amérique du Nord, Europe, Asie-Pacifique et Marchés Émergents

- Défis & Barrières : Défis Techniques, Réglementaires et Obstacles à l’Adoption du Marché

- Perspectives Futures : Innovations Disruptives et Opportunités Stratégiques (2025–2030)

- Annexe : Méthodologie, Sources de Données et Hypothèses du Marché

- Sources & Références

Résumé Exécutif : Résultats Clés & Points Forts du Marché

La fusion de capteurs pour la robotique autonome transforme rapidement les capacités des machines intelligentes dans divers secteurs. En intégrant les données de plusieurs modalités de capteurs—tels que LiDAR, radar, caméras, ultrason et unités de mesure inertielle—la fusion de capteurs permet aux robots d’atteindre une perception robuste, une localisation précise et une prise de décision adaptative dans des environnements complexes. En 2025, le marché de la fusion de capteurs dans la robotique autonome se caractérise par une adoption accélérée, des avancées technologiques et des domaines d’application en expansion.

Les résultats clés indiquent que la convergence de l’intelligence artificielle (IA) et des algorithmes avancés de fusion de capteurs entraîne des améliorations significatives dans la détection d’objets en temps réel, la cartographie et la navigation. Les principaux fabricants de robots, tels que Robert Bosch GmbH et NVIDIA Corporation, investissent massivement dans des plateformes d’intégration multi-capteurs qui exploitent l’apprentissage profond pour une sensibilisation situationnelle améliorée. Cela a abouti à des niveaux d’autonomie plus élevés, notamment dans des secteurs tels que la logistique, la fabrication, l’agriculture et les véhicules autonomes.

Les points forts du marché pour 2025 comprennent :

- Commercialisation Généralisée : Les solutions de fusion de capteurs sont désormais standard dans les nouvelles générations de robots mobiles autonomes (AMRs) et de véhicules guidés automatisés (AGVs), avec des entreprises comme ABB Ltd et OMRON Corporation déployant des systèmes intégrés pour l’automatisation des entrepôts et des usines intelligentes.

- Intégration de l’Informatique de Bord : L’adoption de processeurs d’IA de bord, tels que ceux de NXP Semiconductors N.V., permet le traitement des données de capteurs en temps réel, réduisant la latence et améliorant l’efficacité énergétique des plateformes autonomes.

- Sécurité et Conformité : Les organismes de réglementation, y compris l’Organisation Internationale de Normalisation (ISO), introduisent de nouvelles normes pour la sécurité fonctionnelle et la fiabilité des capteurs, accélérant le déploiement de la fusion de capteurs dans des applications critiques en matière de sécurité.

- Applications Émergentes : Au-delà des cas d’utilisation traditionnels dans l’industrie et l’automobile, la fusion de capteurs gagne du terrain dans la robotique de santé, la livraison urbaine et la surveillance de l’environnement, comme le montrent les initiatives de Intuitive Surgical, Inc. et Boston Dynamics, Inc..

En résumé, 2025 marque une année décisive pour la fusion de capteurs dans la robotique autonome, avec une croissance robuste, une innovation technologique et une diversification des applications façonnant le paysage concurrentiel.

Aperçu du Marché : Définir la Fusion de Capteurs dans la Robotique Autonome

La fusion de capteurs dans la robotique autonome fait référence à l’intégration des données de plusieurs modalités de capteurs—tels que caméras, LiDAR, radar, capteurs ultrason et unités de mesure inertielle (IMUs)—pour créer une compréhension complète et fiable de l’environnement d’un robot. Ce processus est fondamental pour permettre aux systèmes autonomes de percevoir, interpréter et interagir avec des environnements complexes et dynamiques. En combinant les forces et en compensant les faiblesses des capteurs individuels, la fusion de capteurs améliore l’exactitude, la robustesse et la sécurité de la perception et de la prise de décision robotiques.

Le marché de la fusion de capteurs dans la robotique autonome connaît une croissance rapide, alimentée par des avancées en intelligence artificielle, en apprentissage automatique et en technologies de capteurs. Les secteurs clés incluent les véhicules autonomes, l’automatisation industrielle, la logistique, l’agriculture et la robotique de service. Dans ces domaines, la fusion de capteurs est essentielle pour des tâches telles que la localisation et la cartographie simultanées (SLAM), la détection d’obstacles, la reconnaissance d’objets et la planification de trajectoires. Par exemple, dans les véhicules autonomes, la fusion des données provenant de LiDAR et de caméras permet une détection et une classification précises des objets dans des conditions environnementales variées, améliorant ainsi la sécurité et la fiabilité opérationnelle.

Les principaux fournisseurs de technologies et les entreprises de robotique investissent massivement dans la recherche et le développement de la fusion de capteurs. Des organisations comme NVIDIA Corporation et Intel Corporation développent des plateformes matérielles et logicielles avancées qui facilitent l’intégration et le traitement des données de capteurs en temps réel. Pendant ce temps, des fabricants de robots comme Boston Dynamics, Inc. et ABB Ltd intègrent la fusion de capteurs dans leurs systèmes autonomes pour améliorer les capacités de navigation et de manipulation.

Des normes industrielles et des initiatives collaboratives façonnent également le paysage de la fusion de capteurs. Des organisations telles que l’Organisation Internationale de Normalisation (ISO) travaillent sur des lignes directrices pour garantir l’interopérabilité, la sécurité et la fiabilité des systèmes de fusion de capteurs pour la robotique autonome. Ces efforts sont cruciaux alors que le déploiement de robots autonomes s’étend aux espaces publics et aux applications critiques en matière de sécurité.

En perspective pour 2025, le marché de la fusion de capteurs dans la robotique autonome est prêt à continuer d’expansion, alimenté par la demande croissante d’automatisation intelligente et la prolifération d’appareils connectés. Alors que les coûts des capteurs diminuent et que les capacités de calcul s’améliorent, la fusion de capteurs restera une technologie clé, permettant à la prochaine génération de robots autonomes d’opérer avec une plus grande autonomie, efficacité et sécurité.

Taille du Marché 2025 & Prévisions de Croissance (CAGR 2025–2030) : Tendances, Facteurs et Projections

Le marché mondial de la fusion de capteurs dans la robotique autonome est prêt à connaître une expansion significative en 2025, alimentée par des avancées rapides en intelligence artificielle, en apprentissage automatique et en technologies de capteurs. La fusion de capteurs—le processus d’intégration des données de plusieurs capteurs pour produire des informations plus précises, fiables et complètes—est devenue une pierre angulaire du développement de robots autonomes dans des secteurs tels que l’automobile, la logistique, la fabrication et la santé.

Selon les projections de l’industrie, le marché de la fusion de capteurs pour la robotique autonome devrait atteindre un taux de croissance annuel composé (CAGR) robuste entre 2025 et 2030. Cette croissance est alimentée par le déploiement croissant de robots mobiles autonomes (AMRs) et de véhicules guidés automatisés (AGVs) dans les entrepôts et les usines, où la navigation précise et l’évitement des obstacles sont critiques. L’intégration des données provenant de LiDAR, radar, caméras, unités de mesure inertielle (IMUs) et capteurs ultrasonore permet aux robots d’opérer en toute sécurité et efficacement dans des environnements dynamiques.

Les tendances clés façonnant le marché de 2025 comprennent la miniaturisation et la réduction des coûts des capteurs haute performance, l’adoption de l’informatique de bord pour le traitement des données en temps réel, et le développement d’algorithmes avancés de fusion de capteurs qui exploitent l’apprentissage profond. Le secteur automobile, dirigé par des entreprises comme Tesla, Inc. et Toyota Motor Corporation, continue d’investir massivement dans la fusion de capteurs pour les systèmes de conduite autonome, accélérant ainsi la croissance du marché. Pendant ce temps, les leaders de l’automatisation industrielle comme Siemens AG et ABB Ltd intègrent la fusion de capteurs dans les plateformes robotiques pour améliorer la productivité et la sécurité.

Les initiatives gouvernementales et les cadres réglementaires soutenant l’adoption des systèmes autonomes devraient également jouer un rôle clé dans l’expansion du marché. Par exemple, des organisations telles que la National Highway Traffic Safety Administration (NHTSA) et la Commission Européenne développent activement des lignes directrices pour le déploiement sûr des véhicules autonomes, ce qui engendre une demande accrue pour des solutions robustes de fusion de capteurs.

En résumé, le marché de la fusion de capteurs pour la robotique autonome en 2025 est prêt pour une croissance dynamique, soutenue par l’innovation technologique, l’investissement industriel et des environnements réglementaires favorables. Le CAGR pour 2025–2030 devrait rester solide alors que la fusion de capteurs devient de plus en plus essentielle pour le fonctionnement sûr et efficace des robots autonomes de nouvelle génération.

Paysage Concurrentiel : Acteurs Principaux, Startups et Alliances Stratégiques

Le paysage concurrentiel de la fusion de capteurs dans la robotique autonome évolue rapidement, alimenté par des avancées en intelligence artificielle, technologie des capteurs et traitement des données en temps réel. Les géants technologiques établis, les startups innovantes et les alliances stratégiques façonnent le marché, chacun contribuant avec des capacités et des solutions uniques.

Parmi les principaux acteurs, NVIDIA Corporation se distingue avec sa plateforme DRIVE, qui intègre des algorithmes de fusion de capteurs pour la perception et la prise de décision en temps réel dans les véhicules et robots autonomes. Intel Corporation joue également un rôle significatif, notamment grâce à son acquisition de Mobileye, offrant des solutions avancées de fusion de capteurs tant pour les applications automobiles qu’industrielles. Robert Bosch GmbH met à profit son expertise en fabrication de capteurs et systèmes embarqués pour fournir des modules de fusion de capteurs robustes pour une gamme de systèmes autonomes.

Les startups injectent agilité et innovation dans le secteur. Des entreprises comme Oxbotica se concentrent sur des logiciels d’autonomie universelle, permettant une fusion indépendante de capteurs pour des plateformes robotiques diverses. Aurora Innovation, Inc. développe un système de conduite autonome full stack avec une technologie de fusion de capteurs propriétaire, tandis que Ainstein se spécialise dans la fusion de capteurs basés sur radar pour la robotique industrielle et commerciale.

Les alliances stratégiques et les partenariats sont essentiels pour accélérer le développement et le déploiement. Par exemple, NVIDIA Corporation collabore avec Robert Bosch GmbH et Continental AG pour intégrer des plateformes de fusion de capteurs dans les véhicules autonomes de nouvelle génération. Intel Corporation s’associe avec des constructeurs automobiles et des entreprises de robotique pour co-développer des frameworks de fusion de capteurs adaptés à des environnements opérationnels spécifiques. De plus, des consortiums industriels tels que l’Autonomous Vehicle Computing Consortium favorisent la collaboration entre fournisseurs de matériel, logiciels et capteurs afin de standardiser les architectures de fusion de capteurs.

À mesure que le marché mûrit, l’interaction entre les grandes entreprises, les startups agiles et les alliances collaboratives devrait continuer de stimuler l’innovation, réduire les coûts et accélérer l’adoption des technologies de fusion de capteurs dans les secteurs de la robotique autonome en 2025 et au-delà.

Plongée Technologique : Types de Capteurs, Architectures et Approches d’Intégration

La fusion de capteurs est une pierre angulaire de la robotique autonome, permettant aux machines de percevoir et d’interpréter leur environnement avec un niveau de fiabilité et de précision inaccessibles aux systèmes à capteur unique. Cette section se penche sur les principaux types de capteurs, leurs agencements architecturaux et les stratégies d’intégration qui sous-tendent une fusion de capteurs robuste en 2025.

Types de Capteurs

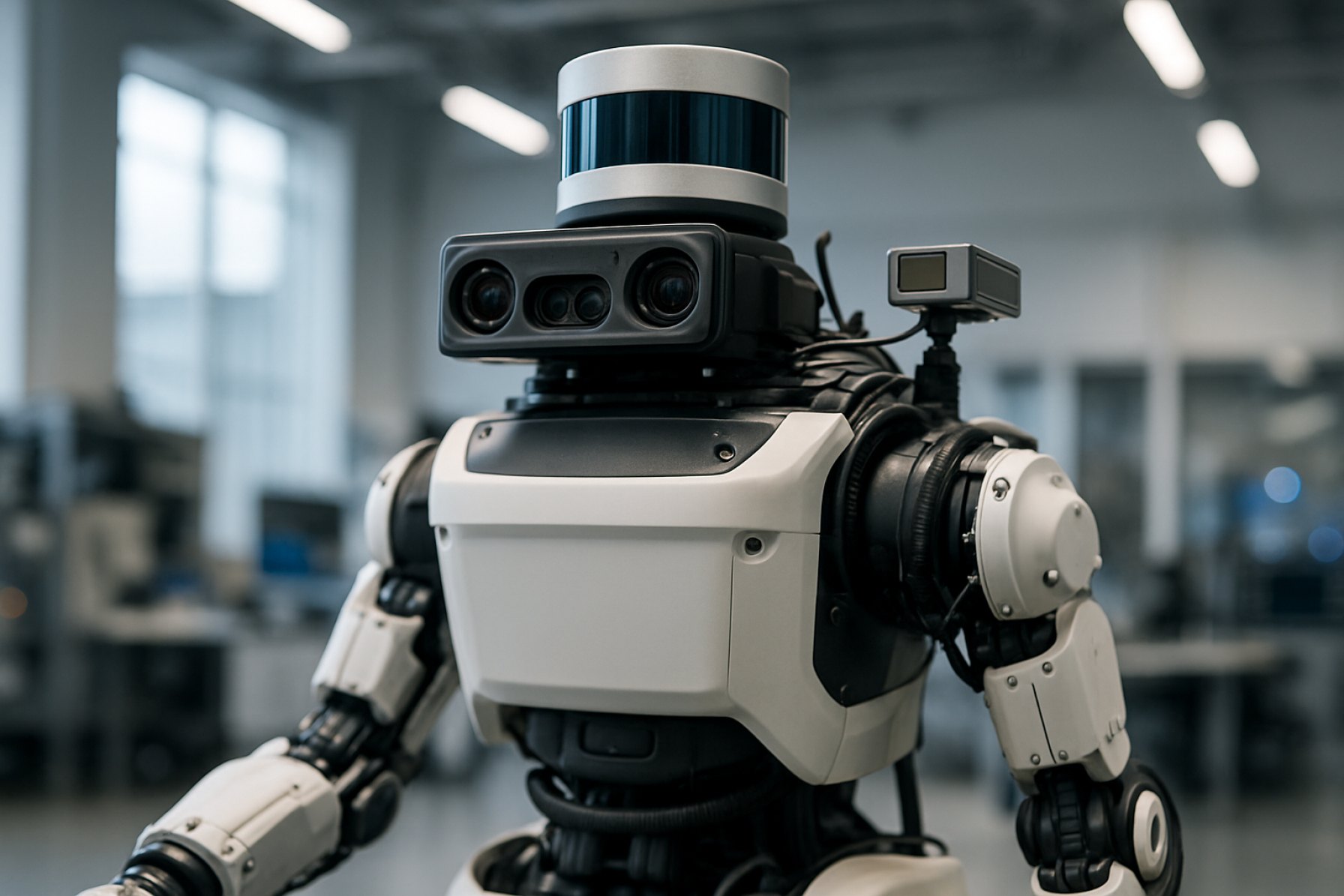

Les robots autonomes utilisent généralement une suite de capteurs complémentaires. Velodyne Lidar, Inc. et Ouster, Inc. sont des fournisseurs leaders de capteurs LiDAR, qui offrent des cartes 3D haute résolution et la détection d’obstacles. Les caméras, monoculaires et stéréo, fournissent des données visuelles riches pour la reconnaissance d’objets et la compréhension de scènes, avec des entreprises comme Basler AG fournissant des solutions d’imagerie de qualité industrielle. Les capteurs radar, tels que ceux de Continental AG, excellent dans des conditions climatiques défavorables et pour la détection à longue portée. Les Unités de Mesure Inertielle (IMUs) fournies par Analog Devices, Inc. délivrent des données précises sur le mouvement et l’orientation, tandis que les capteurs ultrasonores, comme ceux de MaxBotix Inc., sont utilisés pour éviter les obstacles à courte distance.

Architectures pour la Fusion de Capteurs

Les architectures de fusion de capteurs sont généralement classées comme centralisées, décentralisées ou distribuées. Dans les architectures centralisées, toutes les données brutes des capteurs sont transmises à une unité de traitement centrale, où des algorithmes de fusion—souvent basés sur des filtres de Kalman ou l’apprentissage profond—intègrent les informations. Cette approche, bien que gourmand en ressources, permet une optimisation globale et est privilégiée dans les plateformes hautes performances. Les architectures décentralisées traitent les données localement au niveau du capteur ou du module, ne partageant que les informations traitées avec le système central, ce qui réduit la bande passante et la latence. Les architectures distribuées, de plus en plus populaires dans la robotique modulaire et de groupe, permettent le partage de données de pair à pair et la perception collaborative, améliorant la résilience et l’évolutivité du système.

Approches d’Intégration

La fusion de capteurs moderne s’appuie sur l’intégration matérielle et logicielle. L’intégration matérielle, comme on le voit dans les modules de capteurs de Robert Bosch GmbH, combine plusieurs modalités de détection dans un seul package, réduisant la taille et la consommation d’énergie. Du côté logiciel, des plateformes middleware telles que le Robot Operating System (ROS) fournissent des cadres normalisés pour synchroniser, calibrer et fusionner des données de capteurs hétérogènes. Des algorithmes avancés, y compris les réseaux neuronaux profonds et les modèles probabilistes, sont de plus en plus utilisés pour gérer des environnements complexes et dynamiques et compenser les limitations des capteurs individuels.

En résumé, l’évolution des types de capteurs, des architectures de fusion et des stratégies d’intégration propulse la prochaine génération de robotique autonome, permettant des machines plus sûres, fiables et conscientes du contexte.

IA & Apprentissage Automatique dans la Fusion de Capteurs : Permettre une Robotique Plus Intelligente

L’intelligence artificielle (IA) et l’apprentissage automatique (AA) révolutionnent la fusion de capteurs dans la robotique autonome, permettant aux robots d’interpréter des environnements complexes avec une précision et une adaptabilité sans précédent. La fusion de capteurs fait référence au processus d’intégration des données de plusieurs capteurs—tels que caméras, LiDAR, radar et unités de mesure inertielle (IMUs)—pour créer une compréhension complète des alentours d’un robot. Traditionnellement, la fusion de capteurs s’appuyait sur des algorithmes basés sur des règles et des modèles statistiques. Cependant, l’intégration de l’IA et de l’AA a considérablement amélioré la capacité des robots à traiter, interpréter et agir sur les données de capteurs en temps réel.

Les algorithmes d’apprentissage automatique, en particulier les modèles d’apprentissage profond, excellent à extraire des caractéristiques de haut niveau à partir de données brutes des capteurs. Par exemple, les réseaux neuronaux convolutifs (CNN) peuvent traiter des données visuelles provenant des caméras pour identifier des objets, tandis que les réseaux neuronaux récurrents (RNN) peuvent analyser des séquences temporelles provenant des IMUs pour prédire des motifs de mouvement. En combinant ces capacités, les systèmes de fusion de capteurs pilotés par IA peuvent atteindre une perception robuste même dans des conditions difficiles, telles que faible éclairage ou occlusion des capteurs.

Un des principaux avantages de la fusion de capteurs propulsée par l’IA est sa capacité à apprendre des données et à s’améliorer avec le temps. Grâce à l’apprentissage supervisé et non supervisé, les robots peuvent s’adapter à de nouveaux environnements, reconnaître des objets nouveaux et affiner leurs processus de prise de décision. Cette adaptabilité est cruciale pour les véhicules autonomes, les drones et les robots industriels qui opèrent dans des environnements dynamiques et imprévisibles. Par exemple, NVIDIA exploite la fusion de capteurs basée sur l’IA dans ses plateformes de véhicules autonomes, permettant une perception et une navigation en temps réel dans des scénarios de circulation complexes.

De plus, l’IA et l’AA facilitent le développement de pipelines de fusion de capteurs de bout en bout, où les entrées brutes des capteurs sont directement mappées à des actions de contrôle. Cette approche réduit le besoin d’ingénierie manuelle des caractéristiques et permet des solutions plus efficaces et évolutives. Des entreprises comme Bosch Mobility et Intel développent activement des technologies de fusion de capteurs pilotées par l’IA, en se concentrant sur la sécurité, la fiabilité et la performance en temps réel.

Alors que les techniques d’IA et d’AA continuent d’évoluer, la fusion de capteurs dans la robotique autonome deviendra de plus en plus sophistiquée, permettant des robots plus intelligents, plus sûrs et plus polyvalents dans divers secteurs. La recherche et le développement en cours dans ce domaine promettent de débloquer de nouveaux niveaux d’autonomie et d’intelligence pour les systèmes robotiques de nouvelle génération.

Segments d’Application : Industrie, Automobile, Drones, Santé, et Plus

La fusion de capteurs est une technologie fondamentale dans la robotique autonome, permettant aux machines d’interpréter des environnements complexes en intégrant des données provenant de multiples modalités de capteurs. Ses applications s’étendent à une gamme diversifiée d’industries, chacune avec des exigences et des défis uniques.

- Automatisation Industrielle : Dans la fabrication et la logistique, la fusion de capteurs améliore la précision et la sécurité des robots mobiles autonomes (AMRs) et des robots collaboratifs (cobots). En combinant les entrées provenant de LiDAR, caméras, capteurs ultrasonores et unités de mesure inertielle (IMUs), ces robots atteignent une navigation robuste, un évitement des obstacles et une reconnaissance d’objets dans des environnements d’usine dynamiques. Des entreprises comme Siemens AG et ABB Ltd sont à l’avant-garde de l’intégration de la fusion de capteurs dans des solutions d’automatisation industrielle.

- Automobile : Les systèmes avancés d’assistance au conducteur (ADAS) et les véhicules entièrement autonomes dépendent fortement de la fusion de capteurs pour interpréter les conditions routières, détecter les obstacles et prendre des décisions de conduite en temps réel. En fusionnant les données provenant de radar, LiDAR, caméras et capteurs ultrasonores, les véhicules peuvent atteindre des niveaux plus élevés de sensibilisation situationnelle et de sécurité. Les leaders du secteur tels que Robert Bosch GmbH et Continental AG sont à l’avant-garde des plateformes de fusion de capteurs pour les véhicules de prochaine génération.

- Drones et Véhicules Aériens Non Pilotés (UAVs) : Pour les drones, la fusion de capteurs est cruciale pour un vol stable, l’évitement de collisions et la navigation autonome, surtout dans des environnements privés de GPS. L’intégration d’IMUs, de baromètres, de capteurs visuels et de GPS permet aux drones d’opérer en toute sécurité dans des espaces aériens complexes. Des entreprises comme DJI et Parrot Drones SAS exploitent la fusion de capteurs pour améliorer l’autonomie et la fiabilité des drones.

- Robotique Médicale : Dans la robotique médicale, la fusion de capteurs soutient des mouvements précis, la surveillance des patients et une interaction humaine-robot sécurisée. Les robots chirurgicaux, par exemple, combinent des capteurs de force, des retours visuels et des entrées haptiques pour aider les chirurgiens lors de procédures délicates. Des organisations telles que Intuitive Surgical, Inc. intègrent une fusion de capteurs avancée pour améliorer les résultats chirurgicaux et la sécurité des patients.

- Autres Segments Émergents : La fusion de capteurs s’étend également à des secteurs tels que l’agriculture (pour les tracteurs autonomes), la sécurité (pour les robots de surveillance) et l’électronique grand public (pour les robots domestiques intelligents). Des entreprises comme Johnson Controls International plc explorent de nouvelles applications pour la fusion de capteurs dans l’automatisation des bâtiments et la sécurité.

À mesure que les technologies de capteurs évoluent et que la puissance de calcul augmente, la fusion de capteurs continuera d’ouvrir de nouvelles capacités et efficacités dans ces segments d’application et d’autres dans la robotique autonome.

Analyse Régionale : Amérique du Nord, Europe, Asie-Pacifique et Marchés Émergents

La fusion de capteurs pour la robotique autonome connaît des trajectoires de croissance et des schémas d’adoption variés dans différentes régions du monde, façonnés par les forces industrielles locales, les environnements réglementaires et les priorités d’investissement.

Amérique du Nord reste un leader dans l’innovation de la fusion de capteurs, alimentée par des investissements robustes dans les véhicules autonomes, l’automatisation industrielle et les applications de défense. Les États-Unis, en particulier, bénéficient d’un solide écosystème d’entreprises technologiques, d’institutions de recherche et de soutien gouvernemental. Des organisations telles que NASA et DARPA ont financé des recherches significatives sur l’intégration multi-capteurs pour la robotique, tandis que des leaders du secteur privé comme Tesla, Inc. et Boston Dynamics, Inc. font progresser les déploiements dans le monde réel. Les agences réglementaires de la région, y compris la National Highway Traffic Safety Administration, façonnent également activement les normes de fiabilité et de sécurité des capteurs dans les systèmes autonomes.

Europe se caractérise par un fort accent sur la sécurité, l’interopérabilité et la normalisation, avec l’Union Européenne soutenant des initiatives de recherche transfrontalières. La Commission Européenne finance des projets dans le cadre de son programme Horizon Europe, favorisant la collaboration entre universités, startups et fabricants établis. Les géants de l’automobile tels que Robert Bosch GmbH et Continental AG sont à la pointe de la fusion de capteurs pour les systèmes avancés d’assistance au conducteur (ADAS) et les véhicules autonomes. De plus, l’accent mis par la région sur l’IA éthique et la confidentialité des données influence la conception et le déploiement des solutions de fusion de capteurs.

Asie-Pacifique connaît une adoption rapide, en particulier en Chine, au Japon et en Corée du Sud. Les initiatives soutenues par le gouvernement chinois, telles que celles menées par BYD Company Ltd. et Huawei Technologies Co., Ltd., accélèrent l’intégration de la fusion de capteurs dans la fabrication intelligente et la mobilité urbaine. Le secteur robotique bien établi du Japon, avec des entreprises comme Yamaha Motor Co., Ltd. et FANUC Corporation, exploite la fusion de capteurs pour l’automatisation de précision et les robots de service. L’accent mis par la Corée du Sud sur les villes intelligentes et la logistique, soutenu par des entreprises telles que Samsung Electronics Co., Ltd., propulse davantage la croissance régionale.

Les marchés émergents en Amérique Latine, au Moyen-Orient et en Afrique entrent progressivement dans le paysage de la fusion de capteurs, principalement par le biais de transferts de technologies et de projets pilotes. Bien que la fabrication locale soit limitée, des partenariats avec des leaders mondiaux et des centres d’innovation soutenus par le gouvernement favorisent les déploiements initiaux dans l’agriculture, l’exploitation minière et la surveillance des infrastructures.

Défis & Barrières : Défis Techniques, Réglementaires et Obstacles à l’Adoption du Marché

La fusion de capteurs est une technologie fondamentale pour la robotique autonome, permettant aux machines d’interpréter des environnements complexes en intégrant des données de plusieurs capteurs tels que LiDAR, caméras, radar et unités de mesure inertielle. Cependant, le chemin vers une adoption généralisée est semé de défis importants dans les domaines technique, réglementaire et du marché.

Défis Techniques demeurent au premier plan. Atteindre une fusion de capteurs robuste et en temps réel nécessite des algorithmes avancés capables de traiter d’énormes flux de données hétérogènes avec une latence minimale. La synchronisation et la calibration entre des capteurs divers ne sont pas triviales, surtout puisque chaque type de capteur présente des caractéristiques d’erreur et des modes de défaillance uniques. Des facteurs environnementaux—tels que la pluie, le brouillard ou la faible luminosité—peuvent dégrader les performances des capteurs, compliquant ainsi le processus de fusion. De plus, les demandes de calcul d’une fusion haute fidélité nécessitent souvent du matériel spécialisé, augmentant la complexité et le coût du système. Les entreprises de robotique leaders telles que Robert Bosch GmbH et NVIDIA Corporation investissent massivement dans des solutions logicielles et matérielles pour résoudre ces problèmes.

Barrières Réglementaires posent également des obstacles significatifs. Il existe actuellement un manque de normes globales unifiées pour les systèmes de fusion de capteurs dans la robotique autonome, conduisant à des exigences de conformité fragmentées selon les régions. Les organismes de réglementation tels que la National Highway Traffic Safety Administration (NHTSA) aux États-Unis et la Commission Européenne dans l’UE développent encore des cadres pour évaluer la sécurité et la fiabilité des technologies de fusion de capteurs. Cette incertitude réglementaire peut ralentir l’innovation et retarder le déploiement, car les fabricants doivent naviguer à travers des processus de certification et des préoccupations en matière de responsabilité en évolutions constantes.

Obstacles à l’Adoption du Marché compliquent encore le paysage. Le coût élevé des matrices de capteurs avancés et des plateformes de fusion peut être prohibitif, en particulier pour de petites entreprises de robotique et des marchés émergents. De plus, les utilisateurs finaux peuvent être hésitants à faire confiance à des systèmes autonomes tant que les technologies de fusion de capteurs ne démontrent pas une fiabilité cohérente dans le monde réel. Les leaders de l’industrie tels que ABB Ltd et Boston Dynamics, Inc. travaillent à instaurer la confiance grâce à des programmes pilotes et à une transparence des rapports de sécurité, mais une acceptation généralisée nécessitera une éducation continue et une valeur démontrable.

En résumé, bien que la fusion de capteurs soit essentielle pour l’avancement de la robotique autonome, surmonter les barrières techniques, réglementaires et du marché sera critique pour libérer son plein potentiel en 2025 et au-delà.

Perspectives Futures : Innovations Disruptives et Opportunités Stratégiques (2025–2030)

Entre 2025 et 2030, la fusion de capteurs pour la robotique autonome est prête pour des avancées transformationnelles, alimentées par des innovations disruptives et des opportunités stratégiques émergentes. L’intégration de plusieurs modalités de capteurs—tels que LiDAR, radar, caméras, ultrason et unités de mesure inertielle—deviendra de plus en plus sophistiquée, tirant parti des percées en intelligence artificielle et en informatique de bord. Cette évolution devrait améliorer considérablement la perception, la prise de décision et l’adaptabilité des robots autonomes dans des environnements diversifiés.

Une des innovations les plus prometteuses est le développement d’architectures de calcul neuromorphique, qui imitent la capacité du cerveau humain à traiter efficacement les données multisensorielles. Des entreprises comme Intel Corporation et International Business Machines Corporation (IBM) investissent dans de telles technologies, visant à permettre une fusion de capteurs en temps réel avec une consommation d’énergie minimale. Ces avancées permettront aux robots autonomes d’opérer plus efficacement dans des environnements dynamiques et non structurés, tels que les rues urbaines ou les zones sinistrées.

Une autre tendance clé est la montée de cadres de fusion de capteurs collaboratifs, où plusieurs robots ou véhicules partagent et agrègent des données de capteurs par le biais de réseaux sécurisés et à faible latence. Des organisations comme Robert Bosch GmbH et NVIDIA Corporation développent des plateformes facilitant cette intelligence collective, ce qui peut améliorer considérablement la sensibilisation situationnelle et la sécurité dans des applications allant des flottes de livraison autonomes à l’automatisation industrielle.

Stratégiquement, la convergence de la fusion de capteurs avec la connectivité 5G/6G et la robotique dans le cloud ouvrira de nouveaux modèles commerciaux et des opportunités de service. Le déchargement en temps réel du traitement complexe des données de capteurs vers le cloud, exploré par Google Cloud et Microsoft Azure, permettra des plateformes robotiques légères et rentables avec des capacités améliorées. Ce changement devrait accélérer le déploiement de robots autonomes dans la logistique, la santé et l’infrastructure des villes intelligentes.

En regardant vers l’avenir, l’harmonisation réglementaire et l’établissement de normes ouvertes—soutenus par des organismes tels que l’Organisation Internationale de Normalisation (ISO)—seront cruciaux pour l’adoption généralisée. À mesure que les technologies de fusion de capteurs mûrissent, les partenariats stratégiques entre les fabricants de robots, les fournisseurs de capteurs et les développeurs d’IA façonneront le paysage concurrentiel, favorisant l’innovation et garantissant des solutions solides et évolutives pour la prochaine génération de robotique autonome.

Annexe : Méthodologie, Sources de Données et Hypothèses du Marché

Cette annexe décrit la méthodologie, les sources de données et les principales hypothèses du marché utilisées dans l’analyse de la fusion de capteurs pour la robotique autonome en 2025.

- Méthodologie : La recherche a employé une approche mixte, combinant des idées qualitatives d’experts de l’industrie avec des données quantitatives provenant de sources primaires et secondaires. La taille du marché et l’analyse des tendances ont été réalisées en utilisant des approches ascendantes et descendantes, triangulant les données d’expédition, les chiffres de revenu et les taux d’adoption à travers les principaux segments de la robotique (industriels, de service et robots mobiles). La modélisation de scénarios a été utilisée pour tenir compte des taux variables d’adoption de la technologie des capteurs et des changements réglementaires.

- Sources de Données : Les données primaires ont été recueillies à travers des interviews avec des ingénieurs et des chefs de produits au sein des principaux fabricants de robots et de capteurs, y compris Robert Bosch GmbH, Analog Devices, Inc. et Open Source Robotics Foundation. Les données secondaires ont été obtenues à partir de rapports annuels, de livres blancs techniques et de documentation produit d’entreprises telles que NVIDIA Corporation et Intel Corporation. Les informations réglementaires et de normes ont été référencées auprès d’organisations telles que l’Organisation Internationale de Normalisation (ISO) et l’IEEE.

- Hypothèses du Marché : L’analyse suppose une croissance continue de la demande pour la robotique autonome à travers les secteurs de la logistique, de la fabrication et des services, alimentée par des pénuries de main-d’œuvre et des gains d’efficacité. Il est supposé que les coûts des capteurs continueront de diminuer modérément grâce aux avancées dans la fabrication des MEMS et des semi-conducteurs. Les prévisions intègrent l’attente que les algorithmes de fusion de capteurs exploiteront de plus en plus les accélérateurs d’IA et le matériel de calcul de bord, comme en témoigne les feuilles de route des produits d’NVIDIA Corporation et d’Intel Corporation. Les cadres réglementaires sont supposés évoluer progressivement, les normes ISO et IEEE guidant l’interopérabilité et les exigences de sécurité.

- Limitations : L’analyse est limitée par la disponibilité des données publiques sur les algorithmes propriétaires de fusion de capteurs et la nature naissante de certains segments d’application. Les projections du marché sont susceptibles de changer en fonction des avancées technologiques imprévues ou des changements réglementaires.

Sources & Références

- Robert Bosch GmbH

- NVIDIA Corporation

- ABB Ltd

- NXP Semiconductors N.V.

- Organisation Internationale de Normalisation (ISO)

- Intuitive Surgical, Inc.

- Boston Dynamics, Inc.

- Toyota Motor Corporation

- Siemens AG

- Commission Européenne

- Robert Bosch GmbH

- Oxbotica

- Aurora Innovation, Inc.

- Ainstein

- Velodyne Lidar, Inc.

- Ouster, Inc.

- Robot Operating System (ROS)

- Siemens AG

- Parrot Drones SAS

- NASA

- DARPA

- BYD Company Ltd.

- Huawei Technologies Co., Ltd.

- Yamaha Motor Co., Ltd.

- FANUC Corporation

- International Business Machines Corporation (IBM)

- Google Cloud

- IEEE