Sensorfusion för autonom robotik 2025: Hur multisensorintelligens driver nästa våg av autonom innovation. Utforska marknadstillväxt, banbrytande teknologier och strategiska utsikter för de kommande åren.

- Sammanfattning med nyckelfynd och marknadshöjdpunkter

- Marknadsöversikt: Definition av sensorfusion i autonom robotik

- Marknadsstorlek och tillväxtprognos 2025 (CAGR 2025–2030): Trender, drivkrafter och projektioner

- Konkurrenslandskap: Ledande aktörer, startups och strategiska allianser

- Teknologidjupdykning: Sensortyper, arkitekturer och integrationsmetoder

- AI och maskininlärning i sensorfusion: Möjliggör smartare robotik

- Tillämpningssegment: Industriell, Automotive, Droner, Hälsovård och mer

- Regional analys: Nordamerika, Europa, Asien-Stillahavsområdet och tillväxtmarknader

- Utmaningar och hinder: Tekniska, reglerande och marknadsadoptionshinder

- Framtidsutsikter: Störande innovationer och strategiska möjligheter (2025–2030)

- Appendix: Metodik, datakällor och marknadsantaganden

- Källor och referenser

Sammanfattning med nyckelfynd och marknadshöjdpunkter

Sensorfusion för autonom robotik förändrar snabbt möjligheterna för intelligenta maskiner inom olika industrier. Genom att integrera data från flera sensorformer—såsom LiDAR, radar, kameror, ultraljud och inertial mätenheter—möjliggör sensorfusion att robotar kan uppnå robust uppfattning, exakt lokalisering och adaptiv beslutsfattande i komplexa miljöer. År 2025 karakteriseras marknaden för sensorfusion inom autonom robotik av accelererad adoption, teknologiska framsteg och expanderande tillämpningsdomäner.

Nyckelfynd indikerar att konvergensen av artificiell intelligens (AI) och avancerade sensorfusionsalgoritmer driver betydande förbättringar inom realtidsobjektidentifiering, kartläggning och navigation. Ledande robotstillverkare, inklusive Robert Bosch GmbH och NVIDIA Corporation, investerar kraftigt i multisensorintegrationsplattformar som använder djupinlärning för att förbättra situationsuppfattningen. Detta har resulterat i högre autonominivåer, särskilt inom sektorer som logistik, tillverkning, jordbruk och autonoma fordon.

Marknadshöjdpunkter för 2025 inkluderar:

- Utbredd kommersialisering: Sensorfusionslösningar är nu standard i de nya generationerna av autonoma mobila robotar (AMRs) och automatiserade guidade fordon (AGVs), med företag som ABB Ltd och OMRON Corporation som implementerar integrerade system för lagerautomation och smarta fabriker.

- Edge Computing-integration: Antagandet av edge AI-processorer, såsom de från NXP Semiconductors N.V., möjliggör realtidsbearbetning av sensordata, minskar latens och förbättrar energieffektiviteten i autonoma plattformar.

- Säkerhet och efterlevnad: Reglerande myndigheter, inklusive International Organization for Standardization (ISO), introducerar nya standarder för funktionell säkerhet och sensorbetroddhet, vilket accelererar implementeringen av sensorfusion i säkerhetskritiska tillämpningar.

- Framväxande tillämpningar: Utöver traditionella industriella och bilmässiga användningsfall vinner sensorfusion mark i hälsovårdsrobotik, stadsleveranser och miljöövervakning, som demonstreras av initiativ från Intuitive Surgical, Inc. och Boston Dynamics, Inc..

Sammanfattningsvis markerar 2025 ett avgörande år för sensorfusion inom autonom robotik, med robust tillväxt, teknologisk innovation och diversifiering av tillämpningar som formar det konkurrensutsatta landskapet.

Marknadsöversikt: Definition av sensorfusion i autonom robotik

Sensorfusion i autonom robotik avser integreringen av data från flera sensorformer—såsom kameror, LiDAR, radar, ultraljudssensorer och inertial mätenheter (IMUs)—för att skapa en heltäckande och tillförlitlig förståelse av en robots omgivning. Denna process är grundläggande för att möjliggöra autonoma system att uppfatta, tolka och interagera med komplexa, dynamiska omgivningar. Genom att kombinera styrkorna och kompensera för svagheterna hos individuella sensorer, förbättrar sensorfusion noggrannheten, robustheten och säkerheten i robotens perception och beslutsfattande.

Marknaden för sensorfusion inom autonom robotik växer snabbt, drivet av framsteg inom artificiell intelligens, maskininlärning och sensorteknologi. Nyckelsektorer inkluderar autonoma fordon, industriell automation, logistik, jordbruk och serviceroobotik. Inom dessa områden är sensorfusion avgörande för uppgifter som samtidig lokalisering och kartläggning (SLAM), hinderdetektion, objektigenkänning och ruttplanering. Till exempel, i autonoma fordon möjliggör fusionen av data från LiDAR och kameror exakt objektidentifiering och klassificering under varierande miljöförhållanden, vilket förbättrar både säkerhet och driftssäkerhet.

Stora teknikleverantörer och robotföretag investerar kraftigt i forskning och utveckling inom sensorfusion. Organisationer som NVIDIA Corporation och Intel Corporation utvecklar avancerade hårdvara och mjukvaruplattformar som underlättar realtidsintegration och bearbetning av sensordata. Samtidigt inkluderar robotstillverkare som Boston Dynamics, Inc. och ABB Ltd sensorfusion i sina autonoma system för att förbättra navigations- och manipulationsförmåga.

Industriella standarder och samarbetsinitiativ formar också landskapet för sensorfusion. Organisationer som International Organization for Standardization (ISO) arbetar med riktlinjer för att säkerställa interoperabilitet, säkerhet och tillförlitlighet i sensorfusionssystem för autonom robotik. Dessa insatser är avgörande när implementeringen av autonoma robotar expanderar till offentliga platser och säkerhetskritiska tillämpningar.

Med sikte på 2025 är marknaden för sensorfusion inom autonom robotik redo för fortsatt expansion, drivet av den ökande efterfrågan på intelligent automation och spridningen av uppkopplade enheter. När sensorpriserna sjunker och beräkningskapaciteten förbättras, kommer sensorfusion att förbli en hörnstensteknologi, vilket möjliggör nästa generation av autonoma robotar att fungera med större autonomi, effektivitet och säkerhet.

Marknadsstorlek och tillväxtprognos 2025 (CAGR 2025–2030): Trender, drivkrafter och projektioner

Den globala marknaden för sensorfusion i autonom robotik är redo för betydande expansion 2025, drivet av snabba framsteg inom artificiell intelligens, maskininlärning och sensorteknologier. Sensorfusion—processen att integrera data från flera sensorer för att producera mer exakt, pålitlig och omfattande information—har blivit en hörnsten för utvecklingen av autonoma robotar inom branscher som fordon, logistik, tillverkning och hälsovård.

Enligt branschprognoser förväntas marknaden för sensorfusion inom autonom robotik uppnå en robust årlig tillväxttakt (CAGR) mellan 2025 och 2030. Denna tillväxt drivs av den ökande implementeringen av autonoma mobila robotar (AMRs) och automatiserade guidade fordon (AGVs) i lager och fabriker, där precis navigering och hinderundvikande är avgörande. Integreringen av data från LiDAR, radar, kameror, inertial mätenheter (IMUs) och ultraljudssensorer möjliggör att robotar kan arbeta säkert och effektivt i dynamiska miljöer.

Nyckeltrender som formar marknaden 2025 inkluderar miniatyrisering och kostnadsreducering av högpresterande sensorer, antagande av edge computing för realtidsdatabearbetning och utveckling av avancerade sensorfusionsalgoritmer som använder djupinlärning. Fordonssektorn, ledd av företag som Tesla, Inc. och Toyota Motor Corporation, fortsätter att investera kraftigt i sensorfusion för autonoma körsystem, vilket ytterligare accelererar marknadstillväxten. Under tiden integrerar ledarna inom industriell automation, som Siemens AG och ABB Ltd, sensorfusion i robotplattformar för att förbättra produktivitet och säkerhet.

Statliga initiativ och reglerande ramverk som stöder antagandet av autonoma system förväntas också spela en avgörande roll för marknadsexpansionen. Till exempel utvecklar organisationer som National Highway Traffic Safety Administration (NHTSA) och Europeiska kommissionen aktivt riktlinjer för säker implementering av autonoma fordon, vilket i sin tur driver efterfrågan på robusta sensorfusionslösningar.

Sammanfattningsvis är marknaden för sensorfusion inom autonom robotik 2025 redo för dynamisk tillväxt, underbyggd av teknologisk innovation, branschens investeringar och stödjande reglerande miljöer. CAGR för 2025–2030 förväntas förbli stark allteftersom sensorfusion blir allt mer avgörande för säker och effektiv drift av nästa generations autonoma robotar.

Konkurrenslandskap: Ledande aktörer, startups och strategiska allianser

Konkurrenslandskapet för sensorfusion inom autonom robotik utvecklas snabbt, drivet av framsteg inom artificiell intelligens, sensorteknologi och realtidsdatabearbetning. Etablerade teknikjättar, innovativa startups och strategiska allianser formar marknaden, där var och en bidrar med unika kapabiliteter och lösningar.

Bland de ledande aktörerna sticker NVIDIA Corporation ut med sin DRIVE-plattform, som integrerar sensorfusionsalgoritmer för realtidsuppfattning och beslutsfattande i autonoma fordon och robotar. Intel Corporation spelar också en betydande roll, särskilt genom sin förvärv av Mobileye, vilket erbjuder avancerade sensorfusionslösningar för både automotive och industriell robotik. Robert Bosch GmbH utnyttjar sin expertis inom sensorproduktion och inbyggda system för att tillhandahålla robusta sensorfusionsmoduler för en rad autonoma system.

Startups injicerar smidighet och innovation i sektorn. Företag som Oxbotica fokuserar på universell autonom mjukvara, vilket möjliggör sensoragnostisk fusion för olika robotplattformar. Aurora Innovation, Inc. utvecklar ett fullstack-autonomt körsystem med egen sensorfusionsteknologi, medan Ainstein specialiserar sig på radarbaserad sensorfusion för industriell och kommersiell robotik.

Strategiska allianser och partnerskap är kritiska för att påskynda utveckling och implementering. Till exempel samarbetar NVIDIA Corporation med Robert Bosch GmbH och Continental AG för att integrera sensorfusionsplattformar i nästa generations autonoma fordon. Intel Corporation samarbetar med biltillverkare och robotikföretag för att tillsammans utveckla ramverk för sensorfusion anpassade till specifika operativa miljöer. Dessutom främjar branschkonsortier som den autonoma fordonsdatakommissionen samarbete mellan hårdvara-, mjukvara- och sensorleverantörer för att standardisera sensorfusionsarkitekturer.

När marknaden mognar förväntas samspelet mellan etablerade företag, smidiga startups och samarbetsallianser att driva ytterligare innovation, minska kostnader och påskynda antagandet av sensorfusionsteknologier inom autonoma robotiksektorer under 2025 och framåt.

Teknologidjupdykning: Sensortyper, arkitekturer och integrationsmetoder

Sensorfusion är en hörnsten för autonom robotik, vilket möjliggör maskiner att uppfatta och tolka sina miljöer med en nivå av tillförlitlighet och noggrannhet som är ouppnåelig av system med enstaka sensorer. Detta avsnitt går in på de primära sensortyperna, deras arkitektoniska arrangemang och de integrationsstrategier som ligger till grund för robust sensorfusion 2025.

Sensortyper

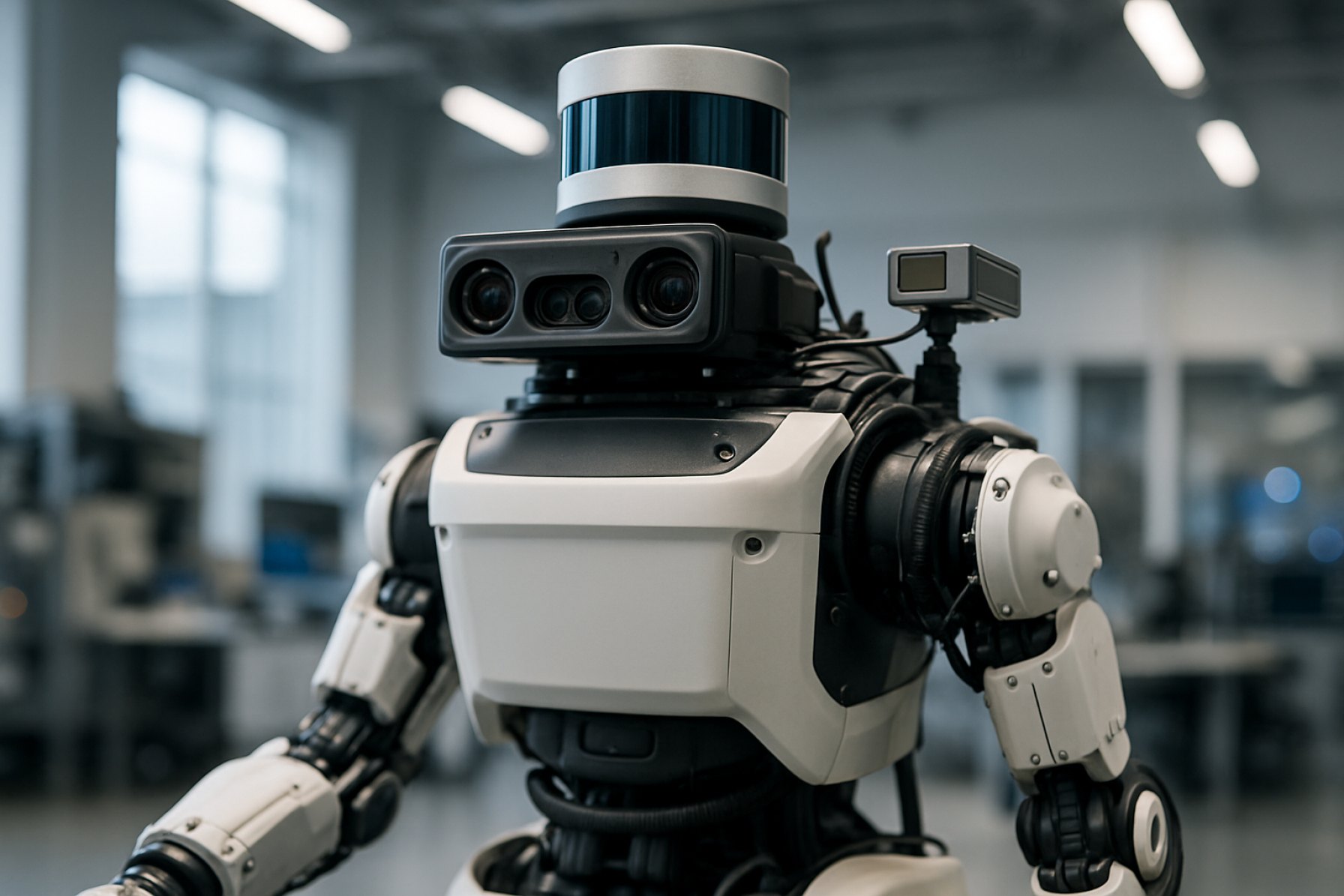

Autonoma robotar använder typiskt en uppsättning komplementära sensorer. Velodyne Lidar, Inc. och Ouster, Inc. är ledande leverantörer av LiDAR-sensorer, som erbjuder högupplöst 3D-kartläggning och hinderdetektion. Kameror, både monokulära och stereo, ger rik visuell data för objektigenkänning och scenförståelse, med företag som Basler AG som tillhandahåller industriella bildlösningar. Radarsensorer, såsom de från Continental AG, excellerar i ogynnsamma väderförhållanden och långdistansdetektion. Inertial Measurement Units (IMUs), som erbjuds av Analog Devices, Inc., tillhandahåller exakt rörelse- och orienteringsdata, medan ultraljudssensorer, som de från MaxBotix Inc., används för närhetshinderundvikande.

Arkitekturer för sensorfusion

Sensorfusionsarkitekturer kategoriseras vanligtvis som centraliserade, decentraliserade eller distribuerade. I centraliserade arkitekturer överförs all råsensorinformation till en central behandlingsenhet, där fusionsalgoritmer—ofta baserade på Kalman-filter eller djupinlärning—integrerar informationen. Denna metod, även om den är beräkningsintensiv, tillåter global optimering och föredras i högpresterande plattformar. Decentraliserade arkitekturer bearbetar data lokalt på sensor- eller modulnivå, vilket endast delar bearbetad information med det centrala systemet, vilket minskar bandbredd och latens. Distribuerade arkitekturer, som blir alltmer populära inom modulär och svärmrrobotik, möjliggör peer-to-peer datadelning och samarbetsuppfattning, vilket förbättrar systemets motståndskraft och skalbarhet.

Integrationsmetoder

Modern sensorfusion utnyttjar både hårdvaru- och mjukvaruintegration. Hårdvarunivåintegration, som ses i sensormoduler från Robert Bosch GmbH, kombinerar flera sensorformer i ett enda paket, vilket minskar storlek och energiförbrukning. På mjukvarusidan tillhandahåller middleware-plattformar, såsom Robot Operating System (ROS), standardiserade ramverk för synkronisering, kalibrering och fusion av heterogen sensordata. Avancerade algoritmer, inklusive djupa neurala nätverk och probabilistiska modeller, används i allt högre grad för att hantera komplexa, dynamiska miljöer och kompensera för individuella sensors begränsningar.

Sammanfattningsvis driver utvecklingen av sensortyper, fusionsarkitekturer och integrationsstrategier nästa generation av autonom robotik, vilket möjliggör säkrare, mer tillförlitliga och kontextmedvetna maskiner.

AI och maskininlärning i sensorfusion: Möjliggör smartare robotik

Artificiell intelligens (AI) och maskininlärning (ML) revolutionerar sensorfusionen i autonom robotik, vilket gör det möjligt för robotar att tolka komplexa miljöer med en oöverträffad noggrannhet och anpassningsförmåga. Sensorfusion avser processen att integrera data från flera sensorer—såsom kameror, LiDAR, radar och inertial mätenheter (IMUs)—för att skapa en heltäckande förståelse av en robots omgivning. Traditionellt har sensorfusion förlitat sig på regelbaserade algoritmer och statistiska modeller. Dock har integreringen av AI och ML avsevärt förbättrat robotars förmåga att bearbeta, tolka och agera på sensordata i realtid.

Maskininlärningsalgoritmer, särskilt djupinlärningsmodeller, utmärker sig vid att extrahera hög-nivåfunktioner från råsensordata. Till exempel kan konvolutionella neurala nätverk (CNNs) bearbeta visuell data från kameror för att identifiera objekt, medan rekurrenta neurala nätverk (RNNs) kan analysera tidsmässiga sekvenser från IMUs för att förutsäga rörelsemönster. Genom att kombinera dessa kapabiliteter kan AI-drivna sensorfusionssystem uppnå robust uppfattning även under utmanande förhållanden, såsom dålig belysning eller sensortäckning.

En av de viktigaste fördelarna med AI-driven sensorfusion är dess förmåga att lära från data och förbättras över tid. Genom övervakad och oövervakad inlärning kan robotar anpassa sig till nya miljöer, känna igen nya objekt och förfina sina beslutsfattande processer. Denna anpassningsförmåga är avgörande för autonoma fordon, drönare och industriella robotar som verkar i dynamiska, oförutsägbara miljöer. Till exempel använder NVIDIA AI-baserad sensorfusion i sina autonoma fordonsplattformar, vilket möjliggör realtidsuppfattning och navigation i komplexa trafikscenarier.

Dessutom underlättar AI och ML utvecklingen av end-to-end sensorfusionspipelines, där råsensoringångar direkt mappas till kontrollåtgärder. Denna metod minskar behovet av manuell funktionsteknik och möjliggör mer effektiva och skalbara lösningar. Företag som Bosch Mobility och Intel utvecklar aktivt AI-drivna sensorfusionslösningar för robotik, med fokus på säkerhet, tillförlitlighet och realtidsprestanda.

Allteftersom AI- och ML-tekniker fortsätter att avancera kommer sensorfusion inom autonom robotik att bli allt mer sofistikerad, vilket möjliggör smartare, säkrare och mer mångsidiga robotar över olika industrier. Den pågående forskningen och utvecklingen inom detta område lovar att låsa upp nya nivåer av autonomi och intelligens för nästa generations robotsystem.

Tillämpningssegment: Industriell, Automotive, Droner, Hälsovård och mer

Sensorfusion är en hörnstensteknologi inom autonom robotik, vilket möjliggör maskiner att tolka komplexa miljöer genom att integrera data från flera sensorformer. Dess tillämpning sträcker sig över ett brett spektrum av industrier, var och en med unika krav och utmaningar.

- Industriell automation: Inom tillverkning och logistik förbättrar sensorfusion noggrannheten och säkerheten hos autonoma mobila robotar (AMRs) och samarbetsrobotar (cobots). Genom att kombinera insatser från lidar, kameror, ultraljudssensorer och inertial mätenheter (IMUs), uppnår dessa robotar robust navigering, hinderundvikande och objektigenkänning i dynamiska fabriksmiljöer. Företag som Siemens AG och ABB Ltd är i framkant av att integrera sensorfusion i industriella automationslösningar.

- Automotive: Avancerade förarassistanssystem (ADAS) och helt autonoma fordon är starkt beroende av sensorfusion för att tolka vägförhållanden, detektera hinder och fatta realtidsbeslut om körning. Genom att sammanfoga data från radar, lidar, kameror och ultraljudssensorer kan fordon uppnå högre nivåer av situational awareness och säkerhet. Branschledare som Robert Bosch GmbH och Continental AG är pionjärer inom sensorfusion plattformar för nästa generations fordon.

- Droner och obemannade flygfarkoster (UAVs): För drönare är sensorfusion avgörande för stabil flygning, kollisionundvikande och autonom navigering, särskilt i GPS-borttagna miljöer. Genom att integrera IMUs, barometrar, visuella sensorer och GPS kan drönare fungera säkert i komplexa luftrum. Företag som DJI och Parrot Drones SAS utnyttjar sensorfusion för att förbättra drönarens autonomi och tillförlitlighet.

- Healthcare Robotics: Inom medicinsk robotik stöder sensorfusion precis rörelse, patientövervakning och säker interaktion mellan människor och robotar. Kirurgiska robotar, till exempel, kombinerar kraftsensorer, visuell feedback och haptiska insatser för att assistera kirurger vid känsliga procedurer. Organisationer som Intuitive Surgical, Inc. integrerar avancerad sensorfusion för att förbättra kirurgiska resultat och patientsäkerhet.

- Andra framväxande segment: Sensorfusion expanderar också till sektorer som jordbruk (för autonoma traktorer), säkerhet (för övervakningsrobotar) och konsumentelektronik (för smarta hemrobotar). Företag som Johnson Controls International plc utforskar nya tillämpningar för sensorfusion inom byggnadsautomation och säkerhet.

När sensorteknologier utvecklas och beräkningskraften ökar kommer sensorfusion att fortsätta öppna nya kapabiliteter och effektiviseringsmöjligheter över dessa och andra tillämpningssegment inom autonom robotik.

Regional analys: Nordamerika, Europa, Asien-Stillahavsområdet och tillväxtmarknader

Sensorfusion för autonom robotik upplever varierande tillväxtbanor och adoptrionsmönster över olika globala regioner, präglade av lokala industriella styrkor, reglerande miljöer och investeringsprioriteringar.

Nordamerika förblir en ledare inom sensorfusionens innovation, drivet av robusta investeringar i autonoma fordon, industriell automation och försvarsapplikationer. USA, i synnerhet, drar nytta av ett starkt ekosystem av teknikföretag, forskningsinstitutioner och statligt stöd. Organisationer som NASA och DARPA har finansierat betydande forskning kring multisensorintegration för robotik, medan privata aktörer som Tesla, Inc. och Boston Dynamics, Inc. gör framsteg med verkliga implementeringar. Regionens regleringsmyndigheter, inklusive National Highway Traffic Safety Administration, arbetar också aktivt med att forma standarder för sensortrohet och säkerhet i autonoma system.

Europa kännetecknas av ett starkt fokus på säkerhet, interoperabilitet och standardisering, med Europeiska unionen som stöder gränsöverskridande forskningsinitiativ. Europeiska kommissionen finansierar projekt under sitt Horizon Europe-program, vilket främjar samarbete mellan universitet, startups och etablerade tillverkare. Stora biltillverkare som Robert Bosch GmbH och Continental AG är i framkant när det gäller sensorfusion för avancerade förarassistanssystem (ADAS) och autonoma fordon. Dessutom påverkar regionens fokus på etisk AI och dataskydd utformningen och implementeringen av sensorfusionslösningar.

Asien-Stillahavsområdet bevittnar snabb adoption, särskilt i Kina, Japan och Sydkorea. Kinas statligt stödda initiativ, såsom de ledda av BYD Company Ltd. och Huawei Technologies Co., Ltd., accelererar integrationen av sensorfusion inom smart tillverkning och urban mobilitet. Japans etablerade robotiksektor, med företag som Yamaha Motor Co., Ltd. och FANUC Corporation, utnyttjar sensorfusion för precisionsautomation och serviceroobotar. Sydkoreas fokus på smarta städer och logistik, stödd av företag som Samsung Electronics Co., Ltd., främjar ytterligare regional tillväxt.

Tillväxtmarknader i Latinamerika, Mellanöstern och Afrika introducerar gradvis sensorfusionens landskap, främst genom tekniköverföring och pilotprojekt. Även om den lokala tillverkningen är begränsad, främjar partnerskap med globala ledare och statligt stödda innovationscentrum initiala implementeringar inom jordbruk, gruvdrift och infrastrukturövervakning.

Utmaningar och hinder: Tekniska, reglerande och marknadsadoptionshinder

Sensorfusion är en grundläggande teknologi för autonom robotik, vilket gör det möjligt för maskiner att tolka komplexa miljöer genom att integrera data från flera sensorer såsom LiDAR, kameror, radar och inertial mätenheter. Men vägen till omfattande adoption är fylld med betydande utmaningar inom tekniska, reglering och marknadsdomäner.

Tekniska utmaningar ligger i framkant. Att uppnå realtids, robust sensorfusion kräver avancerade algoritmer som kan hantera stora, heterogena datastreamar med minimal latens. Synkronisering och kalibrering mellan olika sensorer är inte triviala, särskilt eftersom varje sensortyp har unika felkarakteristika och felmodeller. Miljömässiga faktorer—som regn, dimma eller svagt ljus—kan försämra sensorernas prestanda, vilket försvårar fusionsprocessen. Dessutom kräver de beräkningsmässiga kraven för högfidelityfusion ofta specialiserad hårdvara, vilket ökar systemkomplexiteten och kostnaden. Ledande robotföretag som Robert Bosch GmbH och NVIDIA Corporation investerar kraftigt i både mjukvaru- och hårdvarulösningar för att hantera dessa problem.

Reglerande hinder utgör också betydande hinder. Det finns för närvarande en brist på enhetliga globala standarder för sensorfusionssystem inom autonom robotik, vilket leder till fragmenterade efterlevnadsan krävan på olika regioner. Reglerande organ som National Highway Traffic Safety Administration (NHTSA) i USA och Europeiska kommissionen i EU utvecklar fortfarande ramverk för att bedöma säkerheten och tillförlitligheten hos sensorfusiónsteknologier. Denna reglerande osäkerhet kan sakta ner innovation och fördröja implementering, eftersom tillverkare måste navigera i föränderliga certifieringsprocesser och ansvarsförhållanden.

Marknadsadoptionshinder försvårar också landskapet. Den höga kostnaden för avancerade sensorsystem och fusionsplattformar kan vara avskräckande, särskilt för mindre robotföretag och tillväxtmarknader. Dessutom kan slutanvändare vara tveksamma till att lita på autonoma system tills sensorfusionsteknologier visar konsekvent, verklig tillförlitlighet. Branschledare som ABB Ltd och Boston Dynamics, Inc. arbetar för att bygga förtroende genom pilotprogram och transparent säkerhetsrapportering, men en bred acceptans kräver fortsatt utbildning och påvisad värde.

Sammanfattningsvis, medan sensorfusion är avgörande för utvecklingen av autonom robotik, kommer övervinning av tekniska, reglerande och marknadsbarriärer att vara avgörande för att låsa upp dess fulla potential 2025 och framåt.

Framtidsutsikter: Störande innovationer och strategiska möjligheter (2025–2030)

Mellan 2025 och 2030 är sensorfusion för autonom robotik redo för transformativa framsteg, drivet av störande innovationer och framväxande strategiska möjligheter. Integrationen av flera sensorformer—såsom LiDAR, radar, kameror, ultraljud och inertial mätenheter—kommer att bli alltmer sofistikerad, med hjälp av genombrott inom artificiell intelligens och edge computing. Denna utveckling förväntas avsevärt förbättra perceptionen, beslutsfattandet och anpassningsförmågan hos autonoma robotar i olika miljöer.

En av de mest lovande innovationerna är utvecklingen av neuromorfa datorkonstruktioner, som härmar den mänskliga hjärnans förmåga att effektivt bearbeta multisensorisk data. Företag som Intel Corporation och International Business Machines Corporation (IBM) investerar i sådana teknologier, med målet att möjliggöra realtids sensorfusion med minimal energiförbrukning. Dessa framsteg kommer att göra det möjligt för autonoma robotar att fungera mer effektivt i dynamiska, ostrukturerade miljöer, såsom urbana gator eller katastrofzoner.

En annan nyckeltrend är ökningen av samarbetsinriktade sensorfusionsramverk, där flera robotar eller fordon delar och aggregerar sensordata via säkra, låglatensnätverk. Organisationer som Robert Bosch GmbH och NVIDIA Corporation utvecklar plattformar som underlättar denna kollektiva intelligens, vilket kan förbättra situationsuppfattningen och säkerheten i applikationer som spänner över autonoma leveransflottor till industriell automation.

Strategiskt kommer konvergensen mellan sensorfusion och 5G/6G-anslutning samt molnrobotik att öppna nya affärsmodeller och servicemöjligheter. Realtidsöverföring av komplex bearbetning av sensordata till molnet, som utforskas av Google Cloud och Microsoft Azure, kommer att möjliggöra lätta, kostnadseffektiva robotplattformar med förbättrade kapabiliteter. Denna förändring förväntas påskynda implementeringen av autonoma robotar i logistik, hälsovård och infrastrukturer i smarta städer.

Ser man fram emot, kommer regleringsharmonisering och etableringen av öppna standarder—som främjas av organ som International Organization for Standardization (ISO)—att vara avgörande för omfattande adoption. När sensorfusionsteknologier mognar kommer strategiska partnerskap mellan robotstillverkare, sensorleverantörer och AI-utvecklare att forma det konkurrensutsatta landskapet, främja innovation och säkerställa robusta, skalbara lösningar för nästa generation av autonom robotik.

Appendix: Metodik, datakällor och marknadsantaganden

Denna bilaga beskriver metodologin, datakällorna och nyckelmarknadsantaganden som används i analysen av sensorfusion för autonom robotik 2025.

- Metodik: Forskningen använde en blandad metodansats, som kombinerade kvalitativa insikter från branschexperter med kvantitativa data från primära och sekundära källor. Marknadsstorleks- och trendanalys genomfördes med hjälp av både botten-up och topp-down-ansatser, som triangulerade fraktdata, intäktsfigurer och antagningsgrader över de viktigaste robotsegmenten (industriella, service- och mobila robotar). Scenariomodellering användes för att ta hänsyn till varierande hastigheter av adoption av sensorteknologi och reglerande förändringar.

- Datakällor: Primära data insamlades genom intervjuer med ingenjörer och produktchefer vid ledande robot- och sensorproducenter, inklusive Robert Bosch GmbH, Analog Devices, Inc. och Open Source Robotics Foundation. Sekundära data inhämtades från årsrapporter, tekniska vitböcker och produktdokumentation från företag som NVIDIA Corporation och Intel Corporation. Reglerings- och standardinformation refererades från organisationer som International Organization for Standardization (ISO) och IEEE.

- Marknadsantaganden: Analysen förutsätter fortsatt tillväxt i efterfrågan på autonom robotik över logistik, tillverkning och servicesegment, drivet av arbetskraftsbrister och effektivitetstillväxt. Det antas att sensorpriserna kommer att fortsätta att sjunka måttligt på grund av framsteg inom MEMS och halvledartillverkning. Prognosen inbegriper förväntningar på att sensorfusionsalgoritmer i allt högre grad kommer att utnyttja AI-acceleratorer och edge computing-hårdvara, som framgår av produktroadmaps från NVIDIA Corporation och Intel Corporation. Reglerande ramverk antas utvecklas gradvis, med ISO- och IEEE-standarder som vägleder interoperabilitets- och säkerhetskrav.

- Begränsningar: Analysen begränsas av tillgången på offentlig data om proprietära sensorfusionsalgoritmer och den spirande naturen av vissa tillämpningssegment. Marknadsprognoser är föremål för förändringar beroende på oförutsedda teknologiska genombrott eller reglerande skift.

Källor och referenser

- Robert Bosch GmbH

- NVIDIA Corporation

- ABB Ltd

- NXP Semiconductors N.V.

- International Organization for Standardization (ISO)

- Intuitive Surgical, Inc.

- Boston Dynamics, Inc.

- Toyota Motor Corporation

- Siemens AG

- European Commission

- Robert Bosch GmbH

- Oxbotica

- Aurora Innovation, Inc.

- Ainstein

- Velodyne Lidar, Inc.

- Ouster, Inc.

- Robot Operating System (ROS)

- Siemens AG

- Parrot Drones SAS

- NASA

- DARPA

- BYD Company Ltd.

- Huawei Technologies Co., Ltd.

- Yamaha Motor Co., Ltd.

- FANUC Corporation

- International Business Machines Corporation (IBM)

- Google Cloud

- IEEE