Sensorfusion für autonome Robotik im Jahr 2025: Wie Multi-Sensor-Intelligenz die nächste Welle autonomer Innovation antreibt. Erforschen Sie das Marktwachstum, bahnbrechende Technologien und strategische Aussichten für die kommenden Jahre.

- Zusammenfassung: Wichtige Erkenntnisse & Marktanomalien

- Marktübersicht: Definition der Sensorfusion in der autonomen Robotik

- Marktgröße 2025 & Wachstumsprognose (CAGR 2025–2030): Trends, Treiber und Projektionen

- Wettbewerbslandschaft: Führende Akteure, Startups und strategische Allianzen

- Technologischer Deep Dive: Sensortypen, Architekturen und Integrationsansätze

- KI & Maschinelles Lernen in der Sensorfusion: Intelligente Robotik ermöglichen

- Anwendungssegmente: Industrie, Automobil, Drohnen, Gesundheitswesen und mehr

- Regionale Analyse: Nordamerika, Europa, Asien-Pazifik und Schwellenmärkte

- Herausforderungen & Barrieren: Technische, regulatorische und Markthürden

- Zukunftsausblick: Disruptive Innovationen und strategische Chancen (2025–2030)

- Anhang: Methodologie, Datenquellen und Marktannahmen

- Quellen & Referenzen

Zusammenfassung: Wichtige Erkenntnisse & Marktanomalien

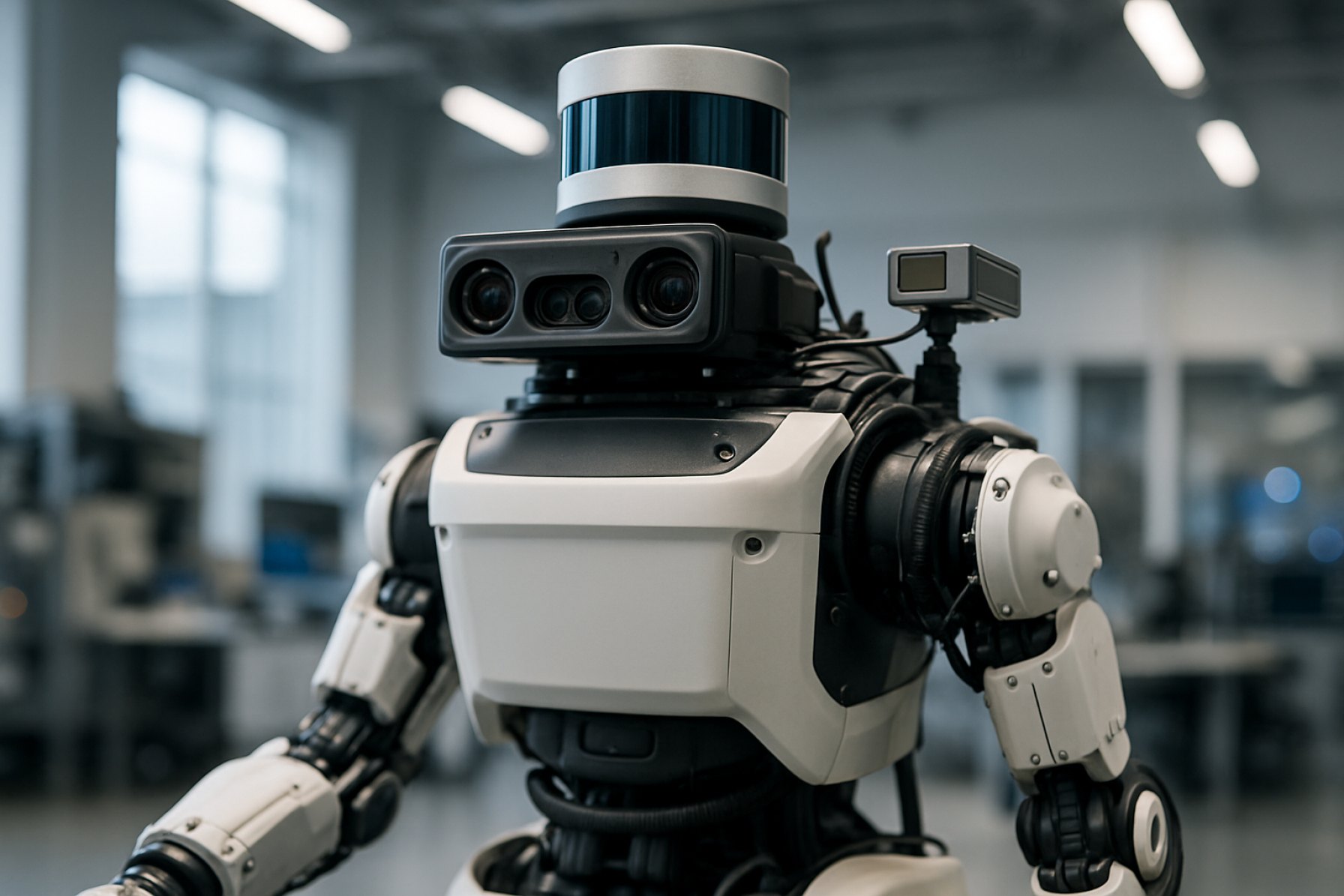

Die Sensorfusion für autonome Robotik transformiert schnell die Fähigkeiten intelligenter Maschinen in verschiedenen Branchen. Durch die Integration von Daten aus mehreren Sensormodulen – wie LiDAR, Radar, Kameras, Ultraschall und inertiale Messgeräte – ermöglicht die Sensorfusion Robotern, eine robuste Wahrnehmung, präzise Lokalisierung und adaptive Entscheidungsfindung in komplexen Umgebungen zu erreichen. Im Jahr 2025 ist der Markt für Sensorfusion in der autonomen Robotik geprägt von beschleunigter Akzeptanz, technologischen Fortschritten und expanding Application Eigenheiten.

Wichtige Erkenntnisse zeigen, dass die Zusammenführung von künstlicher Intelligenz (KI) und fortschrittlichen Sensorfusionsalgorithmen erhebliche Verbesserungen in der Echtzeiterkennung von Objekten, Kartierung und Navigation vorantreibt. Führende Roboterhersteller, darunter Robert Bosch GmbH und NVIDIA Corporation, investieren stark in Plattformen zur Integration von Multi-Sensoren, die Deep Learning für ein verbessertes situatives Bewusstsein nutzen. Dies hat zu höheren Autonomiegraden geführt, insbesondere in Sektoren wie Logistik, Fertigung, Landwirtschaft und autonomen Fahrzeugen.

Markthighlights für 2025 umfassen:

- Weit verbreitete Kommerzialisierung: Sensorfusionslösungen sind jetzt Standard in neuen Generationen autonomer mobiler Roboter (AMRs) und automatisierter geführter Fahrzeuge (AGVs), mit Unternehmen wie ABB Ltd und OMRON Corporation, die integrierte Systeme für die Automatisierung von Lagern und intelligenten Fabriken bereitstellen.

- Edge-Computing-Integration: Die Einführung von Edge-KI-Prozessoren, wie denen von NXP Semiconductors N.V., ermöglicht die Echtzeitverarbeitung von Sensordaten, verringert die Latenz und verbessert die Energieeffizienz in autonomen Plattformen.

- Sicherheit und Compliance: Regulierungsbehörden, einschließlich der International Organization for Standardization (ISO), führen neue Standards für funktionale Sicherheit und Sensorzuverlässigkeit ein, was die Einführung von Sensorfusion in sicherheitskritischen Anwendungen beschleunigt.

- Neu auftretende Anwendungen: Über die traditionellen industriellen und automobilen Anwendungsfälle hinaus gewinnt Sensorfusion in der Robotik im Gesundheitswesen, bei städtischen Lieferungen und der Umweltüberwachung an Bedeutung, wie Initiativen von Intuitive Surgical, Inc. und Boston Dynamics, Inc. zeigen.

Zusammenfassend ist 2025 ein entscheidendes Jahr für die Sensorfusion in der autonomen Robotik, wobei robustes Wachstum, technologische Innovationen und Diversifizierung der Anwendungen die Wettbewerbslandschaft prägen.

Marktübersicht: Definition der Sensorfusion in der autonomen Robotik

Die Sensorfusion in der autonomen Robotik bezieht sich auf die Integration von Daten aus mehreren Sensormodulen – wie Kameras, LiDAR, Radar, Ultraschallsensoren und inertialen Messgeräten (IMUs) – um ein umfassendes und zuverlässiges Verständnis der Umgebung eines Roboters zu schaffen. Dieser Prozess ist grundlegend, um autonomen Systemen zu ermöglichen, komplexe, dynamische Umgebungen wahrzunehmen, zu interpretieren und zu interagieren. Durch die Kombination der Stärken und das Ausgleich von Schwächen einzelner Sensoren verbessert die Sensorfusion die Genauigkeit, Robustheit und Sicherheit der robotischen Wahrnehmung und Entscheidungsfindung.

Der Markt für Sensorfusion in der autonomen Robotik erlebt rapid growth, angetrieben durch Fortschritte in künstlicher Intelligenz, maschinellem Lernen und Sensortechnologien. Wichtige Sektoren umfassen autonome Fahrzeuge, Industrieautomatisierung, Logistik, Landwirtschaft und Servicerobotik. In diesen Bereichen ist die Sensorfusion entscheidend für Aufgaben wie gleichzeitige Lokalisierung und Kartierung (SLAM), Hinderniserkennung, Objekterkennung und Pfadplanung. Zum Beispiel ermöglicht es in autonomen Fahrzeugen, Daten von LiDAR und Kameras zu fusionieren, eine präzise Objekterkennung und -klassifikation unter variierenden Umgebungsbedingungen, was sowohl Sicherheit als auch Betriebzuverlässigkeit verbessert.

Führende Technologieanbieter und Robotikunternehmen investieren stark in die Forschung und Entwicklung von Sensorfusion. Organisationen wie NVIDIA Corporation und Intel Corporation entwickeln fortschrittliche Hardware- und Softwareplattformen, die die Echtzeitintegration und -verarbeitung von Sensordaten erleichtern. In der Zwischenzeit integrieren Robotikhersteller wie Boston Dynamics, Inc. und ABB Ltd die Sensorfusion in ihre autonomen Systeme, um Navigation und Manipulationsfähigkeiten zu verbessern.

Branchenstandards und kollaborative Initiativen prägen ebenfalls die Landschaft der Sensorfusion. Organisationen wie die International Organization for Standardization (ISO) arbeiten an Richtlinien, um Interoperabilität, Sicherheit und Zuverlässigkeit in Sensorfusionssystemen für autonome Robotik sicherzustellen. Diese Bemühungen sind entscheidend, da der Einsatz autonomer Roboter in öffentlichen Räumen und sicherheitskritischen Anwendungen zunimmt.

Mit Blick auf 2025 ist der Sensorfusionmarkt in der autonomen Robotik bereit für kontinuierliches Wachstum, angetrieben durch die steigende Nachfrage nach intelligenter Automatisierung und die Verbreitung vernetzter Geräte. Da die Sensorpreise sinken und die Rechenleistung zunimmt, wird die Sensorfusion weiterhin eine Grundtechnologie bleiben, die der nächsten Generation autonomer Roboter ermöglicht, mit größerer Autonomie, Effizienz und Sicherheit zu operieren.

Marktgröße 2025 & Wachstumsprognose (CAGR 2025–2030): Trends, Treiber und Projektionen

Der globale Markt für Sensorfusion in der autonomen Robotik steht im Jahr 2025 vor einer erheblichen Expansion, angetrieben durch rasante Fortschritte in künstlicher Intelligenz, maschinellem Lernen und Sensortechnologien. Die Sensorfusion – der Prozess der Integration von Daten aus mehreren Sensoren, um genauere, zuverlässigere und umfassendere Informationen zu erzeugen – ist zu einer Grundpfeiler für die Entwicklung autonomer Roboter in Branchen wie Automotive, Logistik, Fertigung und Gesundheitswesen geworden.

Laut Branchenprognosen wird erwartet, dass der Sensorfusionmarkt für autonome Robotik zwischen 2025 und 2030 eine robuste jährliche Wachstumsrate (CAGR) erreichen wird. Dieses Wachstum wird durch die zunehmende Implementierung autonomer mobiler Roboter (AMRs) und automatisierter geführter Fahrzeuge (AGVs) in Lagerräumen und Fabriken angetrieben, wo präzise Navigation und Hindernisvermeidung entscheidend sind. Die Integration von Daten aus LiDAR, Radar, Kameras, inertialen Messgeräten (IMUs) und Ultraschallsensoren ermöglicht es Robotern, sicher und effizient in dynamischen Umgebungen zu arbeiten.

Wesentliche Trends, die den Markt 2025 prägen, sind die Miniaturisierung und Kostenreduzierung leistungsstarker Sensoren, die Einführung von Edge-Computing für die Echtzeitdatenverarbeitung und die Entwicklung fortschrittlicher Sensorfusionsalgorithmen, die auf Deep Learning setzen. Der Automobilsektor, angeführt von Unternehmen wie Tesla, Inc. und Toyota Motor Corporation, investiert weiterhin stark in die Sensorfusion für autonome Fahrsysteme, was das Marktwachstum weiter beschleunigt. Inzwischen integrieren führende Unternehmen der Industrieautomatisierung wie Siemens AG und ABB Ltd die Sensorfusion in Robotikplattformen, um Produktivität und Sicherheit zu steigern.

Regierungsinitiativen und regulatorische Rahmenbedingungen, die die Einführung autonomer Systeme unterstützen, werden ebenfalls eine entscheidende Rolle beim Marktwachstum spielen. Beispielsweise entwickeln Organisationen wie die National Highway Traffic Safety Administration (NHTSA) und die Europäische Kommission aktiv Richtlinien für die sichere Einführung autonomer Fahrzeuge, was wiederum die Nachfrage nach robusten Sensorfusionslösungen antreibt.

Zusammenfassend ist der Sensorfusionmarkt für autonome Robotik im Jahr 2025 auf dynamisches Wachstum eingestellt, gestützt auf technologische Innovation, Industrieinvestitionen und förderliche regulatorische Rahmenbedingungen. Die CAGR für 2025–2030 wird voraussichtlich stark bleiben, da die Sensorfusion zunehmend entscheidend für den sicheren und effizienten Betrieb der nächsten Generation autonomer Roboter wird.

Wettbewerbslandschaft: Führende Akteure, Startups und strategische Allianzen

Die Wettbewerbslandschaft für Sensorfusion in der autonomen Robotik entwickelt sich schnell, angetrieben durch Fortschritte in künstlicher Intelligenz, Sensortechnologie und Echtzeitdatenverarbeitung. Etablierte Technologiegiganten, innovative Startups und strategische Allianzen prägen den Markt und tragen jeweils einzigartige Fähigkeiten und Lösungen bei.

Unter den führenden Akteuren sticht NVIDIA Corporation mit seiner DRIVE-Plattform hervor, die Sensorfusionsalgorithmen für die Echtzeit-Wahrnehmung und -Entscheidungsfindung in autonomen Fahrzeugen und Robotern integriert. Auch die Intel Corporation spielt eine bedeutende Rolle, insbesondere durch die Akquisition von Mobileye, die fortschrittliche Sensorfusionslösungen für die Automobil- und Industrieanwendungen bietet. Robert Bosch GmbH nutzt ihre Expertise in der Sensorherstellung und eingebetteten Systeme, um robuste Sensorfusionsmodule für verschiedene autonome Systeme anzubieten.

Startups bringen Agilität und Innovation in den Sektor. Unternehmen wie Oxbotica konzentrieren sich auf universelle Autonomie-Software, die sensorunabhängige Fusion für verschiedene Robotikplattformen ermöglicht. Aurora Innovation, Inc. entwickelt ein umfassendes autonomes Fahrsystem mit proprietärer Sensorfusionstechnologie, während Ainstein auf radarbasierte Sensorfusion für Industrie- und kommerzielle Robotik spezialisiert ist.

Strategische Allianzen und Partnerschaften sind entscheidend für die Beschleunigung von Entwicklung und Einsatz. Zum Beispiel arbeitet NVIDIA Corporation mit Robert Bosch GmbH und Continental AG zusammen, um Sensorfusionsplattformen in die nächste Generation autonomer Fahrzeuge zu integrieren. Die Intel Corporation kooperiert mit Automobilherstellern und Robotikunternehmen, um maßgeschneiderte Sensorfusionsframeworks für spezifische Betriebsumgebungen zu entwickeln. Darüber hinaus fördern Branchenkonsortien wie das Autonomous Vehicle Computing Consortium die Zusammenarbeit zwischen Hardware-, Software- und Sensoranbietern zur Standardisierung der Sensorfusionsarchitekturen.

Während sich der Markt weiterentwickelt, wird erwartet, dass das Zusammenspiel zwischen etablierten Unternehmen, wendigen Startups und kooperativen Allianzen weitere Innovationen antreibt, Kosten senkt und die Akzeptanz von Sensorfusionstechnologien in der Robotik 2025 und darüber hinaus beschleunigt.

Technologischer Deep Dive: Sensortypen, Architekturen und Integrationsansätze

Die Sensorfusion ist ein Eckpfeiler der autonomen Robotik, die es Maschinen ermöglicht, ihre Umgebung mit einem Maß an Zuverlässigkeit und Genauigkeit, das von Einzelsensor-Systemen nicht erreicht werden kann, zu erkennen und zu interpretieren. Dieser Abschnitt befasst sich mit den wichtigsten Sensortypen, ihren architektonischen Anordnungen und den Integrationsstrategien, die die robuste Sensorfusion im Jahr 2025 unterstützen.

Sensortypen

Autonome Roboter verwenden typischerweise eine Reihe komplementärer Sensoren. Velodyne Lidar, Inc. und Ouster, Inc. sind führende Anbieter von LiDAR-Sensoren, die hochauflösende 3D-Kartierung und Hinderniserkennung bieten. Kameras, sowohl monokular als auch stereo, liefern reichhaltige visuelle Daten zur Objekterkennung und Szenenverständnis, wobei Unternehmen wie Basler AG industrielle Bildlösungen bereitstellen. Radarsensoren, wie die von Continental AG, sind bei schlechten Wetterbedingungen und zur Langstreckenerkennung besonders leistungsfähig. Inertiale Messgeräte (IMUs), die von Analog Devices, Inc. bereitgestellt werden, liefern präzise Bewegungs- und Orientierungsdaten, während Ultraschallsensoren, wie die von MaxBotix Inc., für die Hindernisvermeidung auf kurze Distanz eingesetzt werden.

Architekturen für die Sensorfusion

Sensorfusionsarchitekturen werden im Allgemeinen in zentralisierte, dezentralisierte oder verteilte Architekturen kategorisiert. In zentralisierten Architekturen werden alle Rohsensordaten an eine zentrale Verarbeitungseinheit übertragen, wo Fusionsalgorithmen – oft basierend auf Kalman-Filtern oder Deep Learning – die Informationen zusammenfassen. Dieser Ansatz erlaubt eine globale Optimierung, ist jedoch rechenintensiv und wird in Hochleistungsplattformen bevorzugt. Dezentrale Architekturen verarbeiten Daten lokal auf Sensor- oder Modulebene und teilen nur verarbeitete Informationen mit dem zentralen System, was Bandbreite und Latenz verringert. Verteilte Architekturen, die zunehmend in modularer und Schwarmrobotik beliebt sind, ermöglichen Peer-to-Peer-Datenaustausch und kollaborative Wahrnehmung, was die Systemresilienz und Skalierbarkeit verbessert.

Integrationsansätze

Moderne Sensorfusion nutzt sowohl Hardware- als auch Softwareintegration. Die Hardware-Ebene, die in Sensor Modulen von Robert Bosch GmbH zu sehen ist, kombiniert mehrere Sensormodulen in einem einzigen Paket, wodurch Größe und Energieverbrauch verringert werden. Auf der Softwareseite bieten Middleware-Plattformen wie das Robot Operating System (ROS) standardisierte Rahmenbedingungen für die Synchronisation, Kalibrierung und Fusion heterogener Sensordaten. Fortgeschrittene Algorithmen, einschließlich tiefer neuronaler Netzwerke und probabilistischer Modelle, werden zunehmend eingesetzt, um komplexe, dynamische Umgebungen zu bewältigen und individuelle Sensorbeschränkungen auszugleichen.

Zusammenfassend treibt die Evolution von Sensortypen, Fusionsarchitekturen und Integrationsstrategien die nächste Generation autonomer Robotik voran, die sicherere, zuverlässigere und kontextbewusste Maschinen ermöglicht.

KI & Maschinelles Lernen in der Sensorfusion: Intelligente Robotik ermöglichen

Künstliche Intelligenz (KI) und maschinelles Lernen (ML) revolutionieren die Sensorfusion in der autonomen Robotik und ermöglichen es Robotern, komplexe Umgebungen mit beispielloser Genauigkeit und Anpassungsfähigkeit zu interpretieren. Die Sensorfusion bezieht sich auf den Prozess der Integration von Daten aus mehreren Sensoren – wie Kameras, LiDAR, Radar und inertialen Messgeräten (IMUs) – um ein umfassendes Verständnis der Umgebung eines Roboters zu schaffen. Traditionell verließ sich die Sensorfusion auf regelbasierte Algorithmen und statistische Modelle. Die Integration von KI und ML hat jedoch die Fähigkeit von Robotern, Sensordaten in Echtzeit zu verarbeiten, zu interpretieren und darauf zu reagieren, erheblich verbessert.

Maschinelle Lernalgorithmen, insbesondere Deep-Learning-Modelle, sind hervorragend darin, hochrangige Merkmale aus Rohsensordaten zu extrahieren. Beispielsweise können konvolutionale neuronale Netzwerke (CNNs) visuelle Daten von Kameras verarbeiten, um Objekte zu identifizieren, während rekurrente neuronale Netzwerke (RNNs) zeitliche Sequenzen von IMUs analysieren können, um Bewegungsmuster vorherzusagen. Durch die Kombination dieser Fähigkeiten können KI-gesteuerte Sensorfusionssysteme robuste Wahrnehmung selbst unter herausfordernden Bedingungen erreichen, wie bspw. schwaches Licht oder Sensorverdeckung.

Ein wesentlicher Vorteil der KI-gesteuerten Sensorfusion ist ihre Fähigkeit, aus Daten zu lernen und sich im Laufe der Zeit zu verbessern. Durch überwachtes und unüberwachtes Lernen können Roboter sich an neue Umgebungen anpassen, neuartige Objekte erkennen und ihre Entscheidungsprozesse verfeinern. Diese Anpassungsfähigkeit ist entscheidend für autonome Fahrzeuge, Drohnen und Industrieroboter, die in dynamischen, unvorhersehbaren Umgebungen operieren. Zum Beispiel nutzt NVIDIA KI-basierte Sensorfusion in seinen autonomen Fahrzeugplattformen, um in komplexen Verkehrsszenarien Echtzeitwahrnehmung und -navigation zu ermöglichen.

Darüber hinaus erleichtern KI und ML die Entwicklung von End-to-End-Sensorfusionspipelines, in denen Rohsensoreingaben direkt in Steuerungsaktionen abgebildet werden. Dieser Ansatz reduziert den Bedarf an manueller Merkmalsengineering und ermöglicht effizientere und skalierbare Lösungen. Unternehmen wie Bosch Mobility und Intel entwickeln aktiv KI-gesteuerte Sensorfusionstechnologien für die Robotik mit dem Fokus auf Sicherheit, Zuverlässigkeit und Echtzeitleistung.

Da sich die Techniken von KI und ML weiterentwickeln, wird die Sensorfusion in der autonomen Robotik zunehmend komplexer, was intelligentere, sicherere und vielseitigere Roboter in verschiedenen Branchen ermöglicht. Die laufende Forschung und Entwicklung auf diesem Gebiet verspricht, neue Ebenen von Autonomie und Intelligenz für die nächsten Generationen robotischer Systeme freizusetzen.

Anwendungssegmente: Industrie, Automobil, Drohnen, Gesundheitswesen und mehr

Die Sensorfusion ist eine Eckpfeilertechnologie in der autonomen Robotik, die es Maschinen ermöglicht, komplexe Umgebungen zu interpretieren, indem sie Daten aus mehreren Sensormodulen integriert. Ihre Anwendung erstreckt sich über eine Vielzahl von Branchen, die jeweils einzigartige Anforderungen und Herausforderungen haben.

- Industrieautomatisierung: In der Fertigung und Logistik verbessert die Sensorfusion die Präzision und Sicherheit autonomer mobiler Roboter (AMRs) und kollaborativer Roboter (Cobots). Durch die Kombination von Daten aus LiDAR, Kameras, Ultraschallsensoren und inertialen Messgeräten (IMUs) erreichen diese Roboter eine robuste Navigation, Hindernisvermeidung und Objekterkennung in dynamischen Fabrikumgebungen. Unternehmen wie Siemens AG und ABB Ltd stehen an der Spitze der Integration der Sensorfusion in industrielle Automatisierungslösungen.

- Automobil: Fortgeschrittene Fahrerassistenzsysteme (ADAS) und vollständig autonome Fahrzeuge verlassen sich stark auf Sensorfusion, um Straßenbedingungen zu interpretieren, Hindernisse zu erkennen und in Echtzeit Fahrentscheidungen zu treffen. Durch das Zusammenführen von Daten aus Radar, LiDAR, Kameras und Ultraschallsensoren können Fahrzeuge höhere Grade an situativem Bewusstsein und Sicherheit erreichen. Branchenführer wie Robert Bosch GmbH und Continental AG sind Pioniere von Sensorfusionsplattformen für Fahrzeuge der nächsten Generation.

- Drohnen und unbemannte Luftfahrzeuge (UAVs): Für Drohnen ist die Sensorfusion entscheidend für stabile Flüge, Kollisionvermeidung und autonome Navigation, insbesondere in GPS-beschränkten Umgebungen. Die Integration von IMUs, Barometern, visuellen Sensoren und GPS ermöglicht es Drohnen, sicher in komplexen Lufträumen zu operieren. Unternehmen wie DJI und Parrot Drones SAS nutzen Sensorfusion, um die Autonomie und Zuverlässigkeit von Drohnen zu verbessern.

- Gesundheitsrobotik: In der medizinischen Robotik unterstützt die Sensorfusion präzise Bewegungen, Patientenüberwachung und eine sichere Interaktion zwischen Mensch und Roboter. Chirurgische Roboter kombinieren beispielsweise Kraftsensoren, visuelles Feedback und haptische Eingaben, um Chirurgen bei empfindlichen Verfahren zu unterstützen. Organisationen wie Intuitive Surgical, Inc. integrieren fortschrittliche Sensorfusion, um chirurgische Ergebnisse und Patientensicherheit zu verbessern.

- Andere aufstrebende Segmente: Die Sensorfusion weitet sich auch auf Sektoren wie Landwirtschaft (für autonome Traktoren), Sicherheit (für Überwachungsroboter) und Unterhaltungselektronik (für Smart-Home-Roboter) aus. Unternehmen wie Johnson Controls International plc erforschen neue Anwendungen für Sensorfusion in der Gebäudeautomatisierung und Sicherheit.

Da sich die Sensortechnologien weiterentwickeln und die Rechenleistung steigt, wird die Sensorfusion weiterhin neue Fähigkeiten und Effizienzen in diesen und anderen Anwendungssegmenten der autonomen Robotik freisetzen.

Regionale Analyse: Nordamerika, Europa, Asien-Pazifik und Schwellenmärkte

Die Sensorfusion für autonome Robotik erlebt in verschiedenen globalen Regionen unterschiedliche Wachstumspfaden und Akzeptanzmuster, die durch lokale Branchenschwerpunkte, regulatorische Umgebungen und Investitionsprioritäten geprägt sind.

Nordamerika bleibt ein führendes Land für die Innovation bei der Sensorfusion, angetrieben durch robuste Investitionen in autonome Fahrzeuge, industrielle Automatisierung und Verteidigung. Die Vereinigten Staaten profitieren insbesondere von einem starken Ökosystem aus Technologieunternehmen, Forschungseinrichtungen und staatlicher Unterstützung. Organisationen wie NASA und DARPA haben bedeutende Forschungen zur Integration mehrerer Sensoren für die Robotik finanziert, während private Sektorführer wie Tesla, Inc. und Boston Dynamics, Inc. echte Implementierungen vorantreiben. Die Regulierungsbehörden der Region, einschließlich der National Highway Traffic Safety Administration, gestalten aktiv Standards für die Sensorzuverlässigkeit und Sicherheit in autonomen Systemen.

Europa ist durch ein starkes Augenmerk auf Sicherheit, Interoperabilität und Standardisierung gekennzeichnet, wobei die Europäische Union grenzüberschreitende Forschungsinitiativen unterstützt. Die Europäische Kommission finanziert Projekte im Rahmen ihres Horizon Europe-Programms, um die Zusammenarbeit zwischen Universitäten, Startups und etablierten Herstellern zu fördern. Automobilgiganten wie Robert Bosch GmbH und Continental AG stehen an der Spitze der Sensorfusion für fortschrittliche Fahrerassistenzsysteme (ADAS) und autonome Fahrzeuge. Darüber hinaus beeinflusst die Betonung der Region auf ethische KI und Datenschutz das Design und die Implementierung von Sensorfusionslösungen.

Asien-Pazifik erlebt eine rasante Akzeptanz, insbesondere in China, Japan und Südkorea. Die von der chinesischen Regierung unterstützten Initiativen, wie sie von BYD Company Ltd. und Huawei Technologies Co., Ltd. geleitet werden, beschleunigen die Integration der Sensorfusion in die intelligente Fertigung und urbane Mobilität. Japans etablierter Robotiksektor, mit Unternehmen wie Yamaha Motor Co., Ltd. und FANUC Corporation, nutzt Sensorfusion für präzise Automatisierung und Serviceroboter. Südkoreas Fokus auf intelligente Städte und Logistik, unterstützt von Unternehmen wie Samsung Electronics Co., Ltd., treibt das regionale Wachstum weiter voran.

Schwellenmärkte in Lateinamerika, dem Nahen Osten und Afrika treten allmählich in die Landschaft der Sensorfusion ein, hauptsächlich durch Technologietransfer und Pilotprojekte. Während die lokale Fertigung begrenzt ist, fördern Partnerschaften mit globalen Führungspersönlichkeiten und staatlich geförderte Innovationszentren erste Implementierungen in den Bereichen Landwirtschaft, Bergbau und Infrastrukturüberwachung.

Herausforderungen & Barrieren: Technische, regulatorische und Markthürden

Die Sensorfusion ist eine Eckpfeilertechnologie für autonome Robotik, die es Maschinen ermöglicht, komplexe Umgebungen zu interpretieren, indem sie Daten aus mehreren Sensoren wie LiDAR, Kameras, Radar und inertialen Messgeräten integriert. Der Weg zur breiten Akzeptanz ist jedoch mit erheblichen Herausforderungen in den Bereichen Technik, Regulierung und Markt gespickt.

Technische Herausforderungen stehen weiterhin im Vordergrund. Echtzeit-, robuste Sensorfusion zu erreichen, erfordert fortschrittliche Algorithmen, die in der Lage sind, riesige, heterogene Datenströme mit minimaler Latenz zu verarbeiten. Synchronisation und Kalibrierung zwischen verschiedenen Sensoren sind nicht trivial, insbesondere da jeder Sensortyp einzigartige Fehlermerkmale und Fehlermuster aufweist. Umweltfaktoren – wie Regen, Nebel oder schwaches Licht – können die Sensorleistung beeinträchtigen und den Fusionsprozess komplizieren. Darüber hinaus erfordern die rechnerischen Anforderungen einer hochpräzisen Fusion häufig spezialisierte Hardware, was die Systemkomplexität und -kosten erhöht. Führende Robotikunternehmen wie Robert Bosch GmbH und NVIDIA Corporation investieren stark in Software- und Hardwarelösungen, um diese Probleme anzugehen.

Regulatorische Barrieren stellen ebenfalls erhebliche Hindernisse dar. Derzeit fehlt es an einheitlichen globalen Standards für Sensorfusionssysteme in der autonomen Robotik, was zu fragmentierten Compliance-Anforderungen in verschiedenen Regionen führt. Regulierungsbehörden wie die National Highway Traffic Safety Administration (NHTSA) in den Vereinigten Staaten und die Europäische Kommission in der EU entwickeln nach wie vor Rahmenbedingungen zur Bewertung der Sicherheit und Zuverlässigkeit von Sensorfusionstechnologien. Diese regulatorische Unsicherheit kann Innovationen verlangsamen und die Bereitstellung verzögern, da Hersteller sich an sich entwickelnde Zertifizierungsprozesse und Haftungsfragen gewöhnen müssen.

Marktakzeptanzhindernisse komplizieren die Landschaft weiter. Die hohen Kosten von fortschrittlichen Sensorarrays und Fusionsplattformen können prohibitiv sein, insbesondere für kleinere Robotikfirmen und Schwellenmärkte. Darüber hinaus sind Endnutzer möglicherweise zögerlich, autonome Systeme zu vertrauen, bis die Technologien der Sensorfusion eine konsistente Zuverlässigkeit in der realen Welt demonstrieren. Branchenführer wie ABB Ltd und Boston Dynamics, Inc. arbeiten daran, Vertrauen durch Pilotprogramme und transparente Sicherheitsberichte aufzubauen, aber die breite Akzeptanz erfordert weiterhin Bildung und nachweisbaren Wert.

Zusammenfassend lässt sich sagen, dass, obwohl die Sensorfusion für den Fortschritt der autonomen Robotik wesentlich ist, die Überwindung technischer, regulatorischer und marktbedingter Barrieren entscheidend sein wird, um ihr volles Potenzial im Jahr 2025 und darüber hinaus zu entfalten.

Zukunftsausblick: Disruptive Innovationen und strategische Chancen (2025–2030)

Zwischen 2025 und 2030 steht die Sensorfusion für autonome Robotik vor transformierenden Fortschritten, die durch disruptive Innovationen und aufkommende strategische Chancen angetrieben werden. Die Integration mehrerer Sensormodulen – wie LiDAR, Radar, Kameras, Ultraschall und inertiale Messgeräte – wird zunehmend raffinierter, wobei Durchbrüche in der künstlichen Intelligenz und im Edge Computing genutzt werden. Diese Entwicklung wird voraussichtlich die Wahrnehmung, Entscheidungsfindung und Anpassungsfähigkeit autonomer Roboter in verschiedenen Umgebungen erheblich verbessern.

Eine der vielversprechendsten Innovationen ist die Entwicklung neuromorpher Rechenarchitekturen, die die Fähigkeit des menschlichen Gehirns nachahmen, multisensorische Daten effizient zu verarbeiten. Unternehmen wie Intel Corporation und International Business Machines Corporation (IBM) investieren in solche Technologien, mit dem Ziel, Echtzeit-Sensorfusion mit minimalem Stromverbrauch zu ermöglichen. Diese Fortschritte werden es autonomen Robotern ermöglichen, effektiver in dynamischen, unstrukturierten Umgebungen zu operieren, wie bspw. in urbanen Straßen oder Katastrophengebieten.

Ein weiterer wichtiger Trend ist der Aufstieg von kollaborativen Sensorfusionsframeworks, in denen mehrere Roboter oder Fahrzeuge Sensor Daten über sichere, latenzarme Netzwerke teilen und aggregieren. Organisationen wie Robert Bosch GmbH und NVIDIA Corporation entwickeln Plattformen, die diese kollektive Intelligenz erleichtern, was situatives Bewusstsein und Sicherheit in Anwendungen von autonomen Lieferflotten bis hin zu industrieller Automatisierung erheblich verbessern kann.

Strategisch gesehen wird die Konvergenz von Sensorfusion mit 5G/6G-Konnektivität und Cloud-Robotik neue Geschäftsmodelle und Dienstleistungsmöglichkeiten eröffnen. Das Echtzeit-Entladen komplexer Datenverarbeitung in die Cloud, wie es von Google Cloud und Microsoft Azure erforscht wird, wird leichte, kostengünstige Robotikplattformen mit erweiterten Fähigkeiten ermöglichen. Dieser Wandel wird voraussichtlich die Bereitstellung autonomer Roboter in der Logistik, im Gesundheitswesen und in Infrastruktur der Smart City beschleunigen.

Mit Blick auf die Zukunft werden regulatorische Harmonisierung und die Etablierung offener Standards – von Organisationen wie der International Organization for Standardization (ISO) gefördert – entscheidend für die breite Akzeptanz sein. Während sich die Technologien der Sensorfusion weiterentwickeln, werden strategische Partnerschaften zwischen Robotikherstellern, Sensorlieferanten und KI-Entwicklern die Wettbewerbslandschaft prägen, Innovation fördern und robuste, skalierbare Lösungen für die nächste Generation autonomer Robotik gewährleisten.

Anhang: Methodologie, Datenquellen und Marktannahmen

Dieser Anhang beschreibt die Methodologie, Datenquellen und wichtigsten Marktannahmen, die bei der Analyse der Sensorfusion für autonome Robotik im Jahr 2025 verwendet wurden.

- Methodologie: Die Forschung verwendete einen Mixed-Methods-Ansatz, der qualitative Einblicke von Branchenexperten mit quantitativen Daten aus primären und sekundären Quellen kombiniert. Die Marktgröße und Trendanalyse wurden mit Bottom-up- und Top-down-Ansätzen durchgeführt, wobei Versandsdaten, Umsatzwerte und Akzeptanzraten in den wichtigsten Robotiksegmenten (industrielle, Service- und mobile Roboter) trianguliert wurden. Szenariomodellierung wurde eingesetzt, um unterschiedliche Raten der Annahme von Sensortechnologien und regulatorischen Änderungen zu berücksichtigen.

- Datenquellen: Primärdaten wurden durch Interviews mit Ingenieuren und Produktmanagern führender Robotik- und Sensorhersteller, darunter Robert Bosch GmbH, Analog Devices, Inc. und Open Source Robotics Foundation, gewonnen. Sekundärdaten stammten aus Jahresberichten, technischen Whitepapers und Produktdokumentationen von Unternehmen wie NVIDIA Corporation und Intel Corporation. Informationen zu Regulierungen und Standards wurden von Organisationen wie der International Organization for Standardization (ISO) und IEEE abgerufen.

- Marktannahmen: Die Analyse geht von einem kontinuierlichen Wachstum der Nachfrage nach autonomen Robotern in den Bereichen Logistik, Fertigung und Dienstleistungen aus, angestoßen durch Arbeitskräftemangel und Effizienzgewinne. Es wird angenommen, dass die Sensorpreise aufgrund von Fortschritten in der MEMS- und Halbleiterfertigung weiterhin moderat sinken werden. Die Prognose umfasst die Erwartung, dass Sensorfusionsalgorithmen zunehmend KI-Beschleuniger und Edge-Computing-Hardware nutzen werden, wie dies aus Produktfahrplänen von NVIDIA Corporation und Intel Corporation ersichtlich ist. Es wird angenommen, dass sich regulatorische Rahmenbedingungen schrittweise entwickeln, wobei ISO- und IEEE-Standards Leitlinien für Interoperabilität und Sicherheitsanforderungen bieten.

- Einschränkungen: Die Analyse ist durch die Verfügbarkeit öffentlicher Daten zu proprietären Sensorfusionsalgorithmen und die embryonale Natur einiger Anwendungssegmente begrenzt. Marktprognosen sind Änderungen unterworfen, die durch unvorhergesehene technologische Durchbrüche oder regulatorische Verschiebungen verursacht werden könnten.

Quellen & Referenzen

- Robert Bosch GmbH

- NVIDIA Corporation

- ABB Ltd

- NXP Semiconductors N.V.

- International Organization for Standardization (ISO)

- Intuitive Surgical, Inc.

- Boston Dynamics, Inc.

- Toyota Motor Corporation

- Siemens AG

- Europäische Kommission

- Robert Bosch GmbH

- Oxbotica

- Aurora Innovation, Inc.

- Ainstein

- Velodyne Lidar, Inc.

- Ouster, Inc.

- Robot Operating System (ROS)

- Siemens AG

- Parrot Drones SAS

- NASA

- DARPA

- BYD Company Ltd.

- Huawei Technologies Co., Ltd.

- Yamaha Motor Co., Ltd.

- FANUC Corporation

- International Business Machines Corporation (IBM)

- Google Cloud

- IEEE